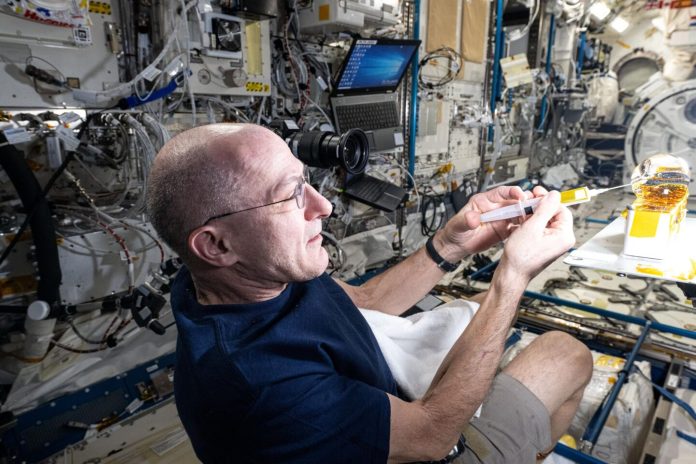

Non è certo un modo convenzionale per celebrare il proprio compleanno quello sperimentato dall’astronauta della NASA Don Pettit.

Immaginate di sfrecciare attraverso l’atmosfera a velocità vertiginosa, sperimentando una forza di decelerazione pari a 4,4 volte la gravità terrestre, per poi atterrare bruscamente nelle vaste e desolate steppe del Kazakistan, un’esperienza così intensa da provocare conati di vomito.

Questa sequenza di eventi straordinari ha segnato il settantesimo compleanno di Pettit, un traguardo anagrafico che nessuno prima di lui aveva mai festeggiato in un modo così singolare.

Un compleanno decisamente fuori dal comune: l’incredibile ritorno di Don Pettit sulla Terra

Sebbene il leggendario John Glenn avesse superato in età Pettit al momento del suo ultimo volo spaziale, all’epoca aveva 77 anni, nessun astronauta dell’età di Pettit aveva mai trascorso un periodo così prolungato in orbita. La sua missione, durata ben 220 giorni, testimonia la sua notevole resistenza fisica e il suo impegno nella ricerca spaziale. Questo prolungato soggiorno nello spazio sottolinea ulteriormente la natura eccezionale del suo rientro sulla Terra proprio nel giorno del suo settantesimo compleanno.

Pochi giorni dopo il suo ritorno dal Cosmo, Don Pettit ha incontrato i giornalisti presso il Johnson Space Center, esprimendo un sentimento comprensibile: la gioia di essere di nuovo sul pianeta Terra. Nonostante la sua profonda passione per l’esplorazione spaziale, per il superamento dei limiti conosciuti e per le preziose osservazioni scientifiche condotte in orbita, Pettit ha ammesso che arriva un momento in cui il richiamo di casa si fa irresistibile. Il suo racconto evidenzia il contrasto tra l’eccitante e ineguagliabile avventura dello spazio e il conforto del ritorno alla familiarità del nostro pianeta.

Una lunga carriera dedicata all’esplorazione orbitale

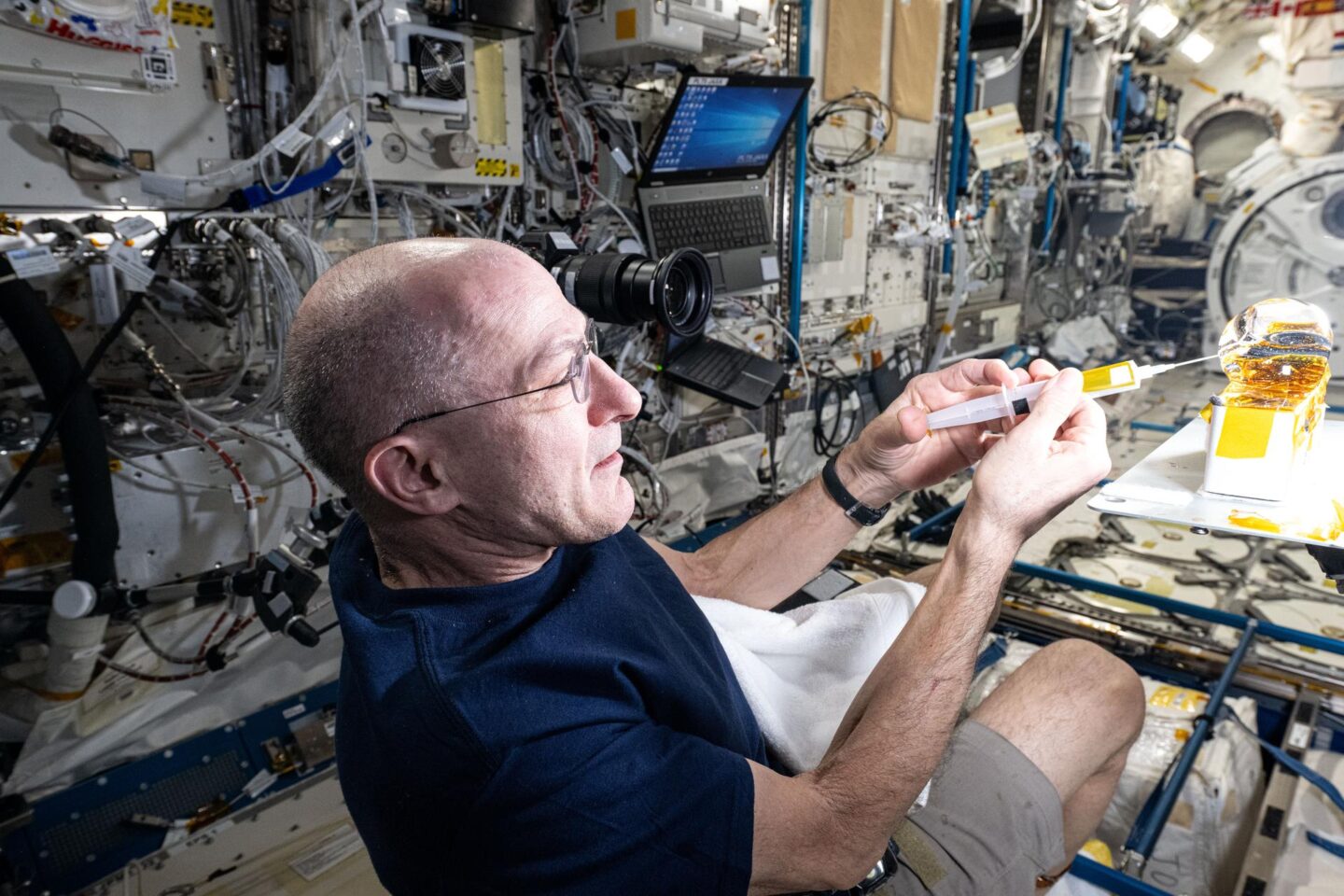

Don Pettit ha intrapreso la sua avventura spaziale all’età di 47 anni, segnando l’inizio di una straordinaria carriera che lo ha visto partecipare a ben tre missioni di lunga durata a bordo della Stazione Spaziale Internazionale. Oltre a questi prolungati soggiorni orbitali, Pettit ha preso parte a una missione più breve con lo Space Shuttle e a ulteriori due missioni dedicate all’assemblaggio e all’integrazione della ISS. Nel complesso, il suo tempo trascorso nello spazio ammonta a un impressionante totale di 590 giorni, un risultato che lo colloca al terzo posto tra gli astronauti della NASA per durata cumulativa in orbita.

Nonostante senta “qualche scricchiolio e lamento” nel corpo, Pettit afferma di sentirsi fondamentalmente come vent’anni fa, ma sottolinea come il ritorno alla gravità rappresenti una vera e propria sfida. Dopo ogni sua missione spaziale, il riadattamento alla forza di gravità terrestre si è rivelato un processo impegnativo. Un aspetto sorprendente, evidenzia Pettit, è che il disagio non deriva tanto dai grandi gruppi muscolari, quanto dai piccoli muscoli posturali, spesso trascurati nella vita quotidiana sulla Terra.

Don Pettit descrive come, durante la sua permanenza sulla stazione spaziale, fosse in grado di eseguire esercizi come squat e stacchi da terra con carichi elevatissimi, fluttuando con la massima agilità nonostante l’assenza di un trapezio sviluppato. Tornare sulla Terra, al contrario, comporta una sensazione di debolezza e difficoltà persino nell’alzarsi. Questa “umiliazione” fisica non è dovuta alla perdita di forza nei grandi muscoli, bensì all’inattività prolungata dei piccoli muscoli stabilizzatori che, in assenza di peso, non sono più sollecitati. Questi muscoli, “in vacanza” per la durata della missione, iniziano a farsi sentire al rientro, richiedendo tempo per riprendere la loro piena funzionalità terrestre.

Per quanto riguarda gli effetti dell’invecchiamento, Pettit riconosce i comuni dolori e rigidità che possono manifestarsi al risveglio sulla Terra. Tuttavia, sottolinea come la microgravità offra un temporaneo sollievo da questi disturbi: “Adoro stare nello Spazio“, confessa, spiegando come il galleggiare durante il sonno permetta al corpo di rilassarsi e ai piccoli dolori di attenuarsi. Questa condizione di assenza di peso gli regala una sensazione di ringiovanimento, facendolo sentire come se avesse trent’anni, libero da dolori e fastidi. Per Pettit, l’orbita terrestre bassa rappresenta un ambiente sorprendentemente benefico per la sua fisiologia.

Un appello alla continuità: oltre la data di decommissioning

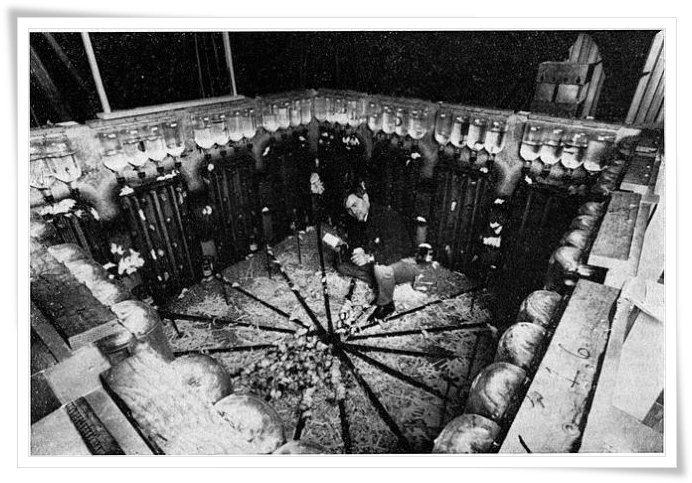

Don Pettit ha sviluppato un profondo legame con la Stazione Spaziale Internazionale (ISS), avendola visitata in ognuno dei suoi quattro voli spaziali. Ha avuto il privilegio di viverci nelle prime fasi di vita della stazione, partecipando alla Spedizione 6 nel lontano 2002. A distanza di oltre vent’anni, Pettit testimonia con entusiasmo come la ISS stia operando a pieno regime, mantenendo la promessa di essere un solido pilastro per la ricerca scientifica all’avanguardia, per gli studi cruciali sui voli spaziali di lunga durata e per innumerevoli altre attività di importanza fondamentale per il progresso umano.

Interrogato sulla sua eventuale nostalgia per la prevista chiusura della stazione nel 2030 – data in cui la NASA intende deorbitare la struttura – Pettit esprime con forza la sua convinzione che il laboratorio orbitale debba continuare a vivere: “Credo fermamente che non sia necessario gettare la stazione spaziale nell’oceano entro il 2030, se non lo vogliamo“, afferma con decisione. Pettit paragona la ISS a un Boeing B-52, un velivolo che, nonostante la sua veneranda età, continuerà a volare per quasi un secolo grazie a continui aggiornamenti e rinnovamenti tecnologici. Allo stesso modo, sostiene Don Pettit, non ci sono limiti intrinseci alla durata operativa della stazione spaziale, se non la volontà della società di investire nel suo mantenimento e nella sua evoluzione.

Forse il desiderio di preservare la ISS è alimentato anche dal suo intimo desiderio di ritornarvi. Don Pettit non esclude categoricamente la possibilità di un altro volo spaziale. Per il momento, la sua priorità è concedere al suo corpo il tempo necessario per riadattarsi completamente alla gravità e godersi preziosi momenti con la sua famiglia. Tuttavia, nel suo cuore, sa che il fascino dello spazio presto si farà sentire di nuovo.

Don Pettit descrive questa sensazione come il “paradosso dell’esploratore“: al ritorno alla civiltà, si sente attratto dall’immensità dello spazio, mentre immerso nella natura selvaggia, desidera ardentemente il conforto della famiglia. Forte dell’esempio di John Glenn, che volò nello Spazio all’età di 76 anni, Pettit, a soli 70 anni, si sente ancora in piena forma per affrontare una o due ulteriori avventure orbitali prima di “appendere al chiodo i suoi razzi“.

Per maggiori informazioni visita il sito ufficiale della NASA.