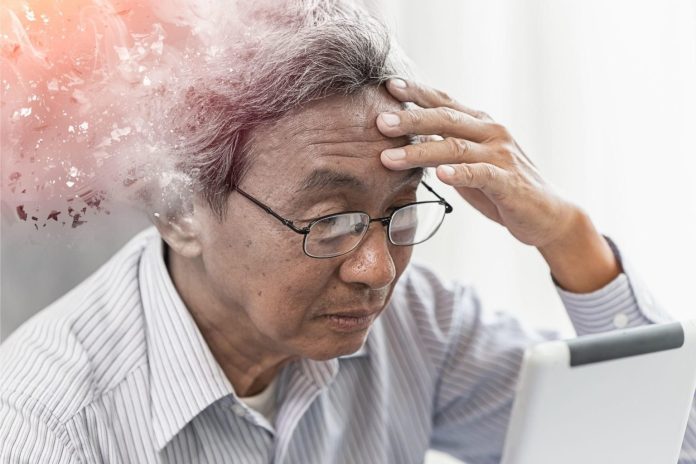

Si dice che Albert Einstein abbia trascorso le sue ultime ore a scarabocchiare qualcosa su un pezzo di carta nell’ultimo tentativo di formulare una teoria del tutto. Circa 60 anni dopo, un’altra figura leggendaria della fisica teorica, Stephen Hawking, potrebbe essere morto con pensieri simili.

Sappiamo che Hawking pensava che qualcosa chiamata “teoria M” fosse la soluzione migliore per una teoria completa dell’universo. Ma cos’è?

Dalla formulazione della teoria della relatività generale di Einstein nel 1915, ogni fisico teorico ha sognato di conciliare la nostra comprensione del mondo infinitamente piccolo di atomi e particelle con quella della scala infinitamente grande del cosmo. Mentre il secondo è efficacemente descritto dalle equazioni di Einstein, il primo è previsto con straordinaria accuratezza dal cosiddetto Modello Standard delle interazioni fondamentali.

La nostra attuale comprensione è che l’interazione tra oggetti fisici è descritta da quattro forze fondamentali. Due di loro – gravità ed elettromagnetismo – sono rilevanti per noi a livello macroscopico, li affrontiamo nella nostra vita di tutti i giorni. Le altre due, denominate interazioni forte e debole, agiscono su scala molto piccola e diventano rilevanti solo quando si tratta di processi subatomici.

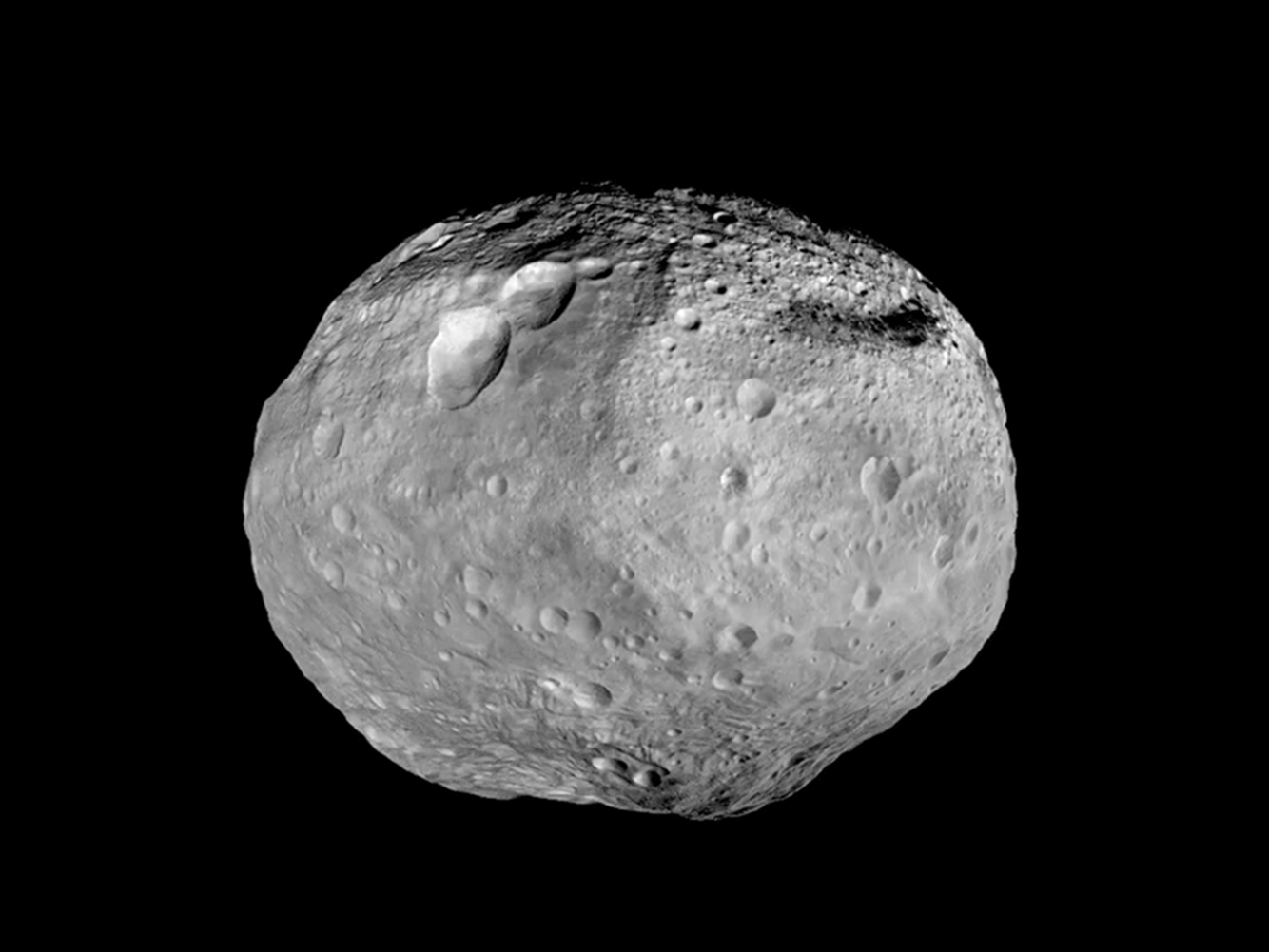

Il modello standard delle interazioni fondamentali fornisce un quadro unificato per tre di queste forze, ma la gravità non può essere inclusa in modo coerente in questo quadro. Nonostante la sua accurata descrizione di fenomeni su larga scala come l’orbita di un pianeta o la dinamica delle galassie, la relatività generale si rompe a distanze molto brevi. Secondo il modello standard, tutte le forze sono mediate da particelle specifiche. Per la gravità, una particella chiamata gravitone fa il suo lavoro. Ma quando si cerca di calcolare come interagiscono questi gravitoni, appaiono infiniti senza senso.

Una teoria coerente della gravità dovrebbe essere valida a qualsiasi scala e dovrebbe tenere conto della natura quantistica delle particelle fondamentali. Ciò conterrebbe la gravità in una struttura unificata con le altre tre interazioni fondamentali, fornendo così la celebre teoria del tutto. Naturalmente, dalla morte di Einstein nel 1955, sono stati fatti molti progressi e oggi il nostro miglior candidato va sotto il nome di teoria M.

Rivoluzione delle stringhe

Per comprendere l’idea di base della teoria M, bisogna risalire agli anni ’70, quando gli scienziati si resero conto che, invece di descrivere l’universo sulla base di particelle puntiformi, lo si poteva descrivere in termini di minuscole stringhe oscillanti (tubi di energia). Questo nuovo modo di pensare ai costituenti fondamentali della natura si è rivelato risolvere molti problemi teorici. Soprattutto, una particolare oscillazione della corda potrebbe essere interpretata come un gravitone. E a differenza della teoria standard della gravità, la teoria delle stringhe può descrivere matematicamente le sue interazioni senza ottenere strani infiniti. Così, la gravità è stata finalmente inclusa in un quadro unificato.

Dopo questa entusiasmante scoperta, i fisici teorici hanno dedicato molti sforzi alla comprensione delle conseguenze di questa idea seminale. Tuttavia, come spesso accade con la ricerca scientifica, la storia della teoria delle stringhe è caratterizzata da alti e bassi. All’inizio, le persone erano perplesse perché prevedeva l’esistenza di una particella che viaggia più velocemente della velocità della luce, soprannominata “tachione“. Questa previsione era in contrasto con tutte le osservazioni sperimentali e gettava seri dubbi sulla teoria delle stringhe.

Tuttavia, questo problema è stato risolto all’inizio degli anni ’80 con l’introduzione di qualcosa chiamato “supersimmetria” nella teoria delle stringhe. Questo predice che ogni particella ha un superpartner e, per una straordinaria coincidenza, la stessa condizione elimina effettivamente il tachione. Questo primo successo è comunemente noto come ” la prima rivoluzione delle corde “.

Un’altra caratteristica sorprendente è che la teoria delle stringhe richiede l’esistenza di dieci dimensioni spaziotemporali. Attualmente ne conosciamo solo quattro: profondità, altezza, larghezza e tempo. Sebbene questo possa sembrare un grosso ostacolo, sono state proposte diverse soluzioni e oggigiorno è considerato una caratteristica notevole, piuttosto che un problema.

Ad esempio, potremmo in qualche modo essere costretti a vivere in un mondo a quattro dimensioni senza alcun accesso alle dimensioni extra. Oppure le dimensioni extra potrebbero essere “compattezzate” su una scala così piccola da non notarle. Tuttavia, diverse compattazioni porterebbero a valori diversi delle costanti fisiche e, quindi, a leggi fisiche diverse. Una possibile soluzione è che il nostro universo sia solo uno dei tanti in un “multiverso” infinito, governato da diverse leggi della fisica. Può sembrare strano, ma molti fisici teorici si stanno avvicinando a questa idea.

Teoria M

Ma c’era ancora una questione urgente che infastidiva i teorici delle stringhe. Una classificazione approfondita ha mostrato l’esistenza di cinque diverse teorie delle stringhe coerenti e non era chiaro il motivo per cui la natura ne avrebbe scelto una su cinque.

Questo è quando la teoria M è entrata in gioco. Durante la seconda rivoluzione delle stringhe, nel 1995, i fisici hanno proposto che le cinque teorie delle stringhe coerenti siano in realtà solo facce diverse di una teoria unica che vive in undici dimensioni spaziotemporali ed è nota come teoria M.

Ciascuna include delle teorie delle stringhe in diversi contesti fisici, ma è comunque valida per tutte. Questo quadro estremamente affascinante ha portato la maggior parte dei fisici teorici a credere nella teoria M come teoria di tutto: è anche matematicamente più coerente di altre teorie candidate.

Tuttavia, finora la teoria M ha faticato a produrre previsioni che possano essere verificate mediante esperimenti. La supersimmetria è attualmente in fase di test presso il Large Hadron Collider. Se gli scienziati trovassero prove di superpartner, ciò alla fine rafforzerebbe la teoria M. Ma rimane ancora una sfida per gli attuali fisici teorici produrre previsioni verificabili e per i fisici sperimentali impostare esperimenti per testarle.

La maggior parte dei grandi fisici e cosmologi sono spinti dalla passione a trovare quella bella e semplice descrizione del mondo che può spiegare tutto. E anche se non siamo ancora arrivati, non avremmo una possibilità senza le menti acute e creative di persone come Hawking.