Le armi nucleari possono uccidere milioni di persone, spazzare via intere città e rendere sterile il suolo nella zona del fallout per generazioni.

Secondo l’Associazione per il controllo degli armamenti, i nove stati nucleari del mondo – Cina, Francia, India, Israele, Corea del Nord, Pakistan, Russia, Regno Unito e Stati Uniti – hanno un arsenale combinato di circa 13.000 testate nucleari. Ciò solleva alcune domande ovvie. Ad esempio, quali sono le possibilità di una denotazione accidentale? E quali misure sono in atto per garantire che non esplodano inavvertitamente?

Mentre alcune delle prime armi nucleari erano fragili o volatili, le moderne armi nucleari sono progettate con cura e con alti livelli di sicurezza, protezione e affidabilità, ha affermato Philipp C. Bleek, professore associato di studi sulla non proliferazione e il terrorismo presso il Middlebury Institute of International Studies di Monterey in California.

Ciò significa che la denotazione accidentale è estremamente improbabile.

“Un’arma nucleare in un ambiente sicuro, ovvero immagazzinata, non dovrebbe superare una probabilità su un miliardo di esplodere prematuramente”, ha detto Bleek. “In un ambiente anormale, la probabilità è una su un milione”. Un ambiente anormale, può includere situazioni come “un incendio nel luogo in cui è immagazzinata o un incidente di un aereo che le trasporta”. Entrambi questi esempi, ha osservato Bleek, si sono verificati in passato e le armi nucleari non sono esplose.

“Le armi sono progettate per essere ‘sicure in un punto'”, ha aggiunto Bleek, quindi se un singolo componente esplosivo di un’arma viene fatto esplodere accidentalmente, la probabilità di una resa nucleare superiore a quattro chilotoni non dovrebbe superare uno su un milione. A titolo di paragone, la bomba sganciata su Hiroshima era di 15 chilotoni.

Per garantire che le bombe nucleari abbiano solo una possibilità su un miliardo (o milione) di esplodere a seguito di qualsiasi tipo di incidente o inconveniente, il Dipartimento dell’Energia degli Stati Uniti impone che queste armi “includano più serie di collegamenti forti, anelli deboli e barriere annidate l’una nell’altra, con ciascun sottosistema di sicurezza ampiamente indipendente dagli altri”.

Questa direttiva garantisce che i diversi sottosistemi dell’arma siano sufficientemente indipendenti. Utilizzando due di questi sottosistemi di sicurezza si otterrà una garanzia del sistema di uno su un milione, mentre tre ne forniranno uno su un miliardo. La sicurezza dalla detonazione accidentale, secondo il Dipartimento dell’Energia degli Stati Uniti, “è possibile solo se le modalità di guasto per ciascun sottosistema di sicurezza sono veramente indipendenti l’una dall’altra”.

Morte e distruzione

Ad oggi, solo due bombe atomiche sono state sganciate con l’unico intento di provocare morte e distruzione su vasta scala: i bombardamenti statunitensi delle città giapponesi di Hiroshima e Nagasaki rispettivamente il 6 e il 9 agosto 1945, che hanno ucciso circa 214.000 persone, e ha causato gravi lesioni e malattie a centinaia di migliaia di altre.

Negli 80 anni successivi, la nostra comprensione di come funzionano le armi nucleari è migliorata, al punto che le armi odierne sono molto più potenti e potenzialmente distruttive. La B83, la bomba più potente della collezione nucleare degli Stati Uniti, ha una resa massima di 1,2 megatoni, il che la rende 60 volte più potente della bomba sganciata su Nagasaki. L’archivio delle armi nucleari suggerisce che 650 di questi sono attualmente in servizio attivo negli Stati Uniti.

Data la posta in gioco, quali protocolli sono in atto per prevenire la morte e la distruzione?

Alcune delle misure di sicurezza più importanti includono il monitoraggio attento dei componenti e la sostituzione tempestiva di moduli o parti obsoleti o ridondanti.

“Le armi nucleari hanno componenti di durata limitata, in particolare il cosiddetto gas di spinta che fornisce combustibile per la fusione”, ha detto Bleek. La fusione si verifica quando due atomi leggeri si legano insieme, o si fondono, per crearne uno più pesante. Tuttavia, quando il materiale radioattivo presente nelle armi nucleari decade, deve essere reintegrato in ordine.

Ad esempio, il trizio, un isotopo radioattivo dell’idrogeno, ha un’emivita di soli 12 anni, il che significa che metà della quantità decade in quel lasso di tempo e quindi è necessario tenere d’occhio le armi contenenti trizio.

Anche altri componenti hanno una vita utile limitata, quindi le armi devono essere rigenerate occasionalmente. “Il componente più longevo di un’arma nucleare è la fossa di plutonio, che può avere una vita utile superiore a cento anni”, ha spiegato Bleek. Questi pozzi sono elementi centrali chiave nelle testate nucleari. Sono gusci sferici di plutonio che hanno generalmente le dimensioni di un pallone da calcio. Quando un’arma nucleare viene fatta esplodere, il plutonio innesca una piccola reazione nucleare. Questa, a sua volta, crea un’esplosione secondaria più consistente nel carico utile nucleare principale. In poche parole, la fossa contiene il materiale che consente a un’arma nucleare di diventare una bomba.

Controlli d’uso

“Le moderne armi nucleari hanno i cosiddetti controlli d’uso, che impediscono la loro detonazione indesiderata”, ha detto Bleek. “Ad esempio, una testata missilistica deve sperimentare determinate condizioni prima di armarsi, in modo che non possa – o almeno sia estremamente improbabile – esplodere nel suo silo o a bordo del suo sottomarino”.

Inoltre, le moderne armi nucleari sono state accuratamente progettate per garantire che, quando sono inattive, i materiali che devono combinarsi per creare un’esplosione nucleare siano tenuti separati. Fino a sei dispositivi di sicurezza vengono utilizzati in un’arma nucleare per garantire che non si verifichi una detonazione involontaria. Alcuni di questi dispositivi di sicurezza, come gli interruttori inerziali (che scattano in caso di urto o vibrazione) o gli accelerometri (che misurano la vibrazione o l’accelerazione del movimento di una struttura), consentiranno l’inserimento solo se sottoposti a un’azione molto specifica o ad un grado di accelerazione o vibrazione in un determinato periodo di tempo.

Nel frattempo, anche il materiale nucleare stesso ha una protezione. “Le armi nucleari contengono una certa quantità di uranio o plutonio altamente arricchito: se ne hai abbastanza di questo materiale in un volume abbastanza piccolo (una cosiddetta “massa critica”) esploderà automaticamente in una reazione nucleare”, ha dichiarato Mark Bell, professore associato di scienze politiche presso l’Università del Minnesota.

Affinché un’arma nucleare possa esplodere, ha detto Bell, è necessario intraprendere un’azione deliberata per riunire il materiale. In genere, questo viene fatto in due modi. Un modo, utilizzato nei cosiddetti dispositivi a pistola, è quello di “sparare un pezzo di uranio altamente arricchito in un altro pezzo di uranio altamente arricchito”, in modo che i due pezzi insieme formino una “massa critica” e inneschino un’esplosione. Questo è il tipo più semplice di arma nucleare e il tipo di bomba che gli Stati Uniti usarono a Hiroshima durante la seconda guerra mondiale.

“L’alternativa, che è più complicata ma ti consente di creare un’esplosione più grande, è prendere una sfera cava di plutonio e schiacciarla in una palla per creare una massa critica che poi esplode”, ha detto Bell. “Ma, poiché il materiale non è una massa critica quando l’arma è semplicemente seduta, non c’è molto pericolo che esploda spontaneamente”. Questo tipo di denotazione, chiamato dispositivo di implosione, fu quello che gli Stati Uniti usarono a Nagasaki.

Ulteriori misure di sicurezza

Sebbene sia essenziale stabilire misure per garantire che un’arma nucleare non esploda spontaneamente, altre considerazioni richiedono un maggiore investimento di tempo e riflessione.

“È più importante prevenire l’uso non autorizzato, il furto, ecc. che evitare che esplodano accidentalmente”, ha detto Bell.

“Sarebbe difficile per una persona media far esplodere un’arma nucleare se si imbattesse in essa”, ha aggiunto Bell. “Negli Stati Uniti, ad esempio, ci sono dispositivi chiamati Permissive Action Links (PAL) integrati nelle armi nucleari che rendono molto difficile per chiunque armare o far esplodere un’arma nucleare senza l’autorizzazione o i codici appropriati”.

Tuttavia, sia Bell che Bleek hanno sottolineato che il rischio principale è causato dalle persone che hanno la capacità di sparare armi per capriccio, al contrario di qualsiasi tipo di detonazione accidentale, è molto più probabile che sia la causa di qualsiasi futura bomba e disastro correlato.

“A mio avviso, l’uso nucleare accidentale o non autorizzato è molto meno probabile dell’uso deliberato ma avventato”, ha detto Bell. “Non ci sono praticamente controlli ed equilibri per impedire al presidente degli Stati Uniti, ad esempio, di ordinare il lancio di armi nucleari. In effetti, l’intero sistema è essenzialmente impostato per garantire che possano farlo. Questo è ciò che mi tiene sveglio la notte molto più delle preoccupazioni per incidenti o armi nucleari che esplodono spontaneamente”, ha concluso Bell.

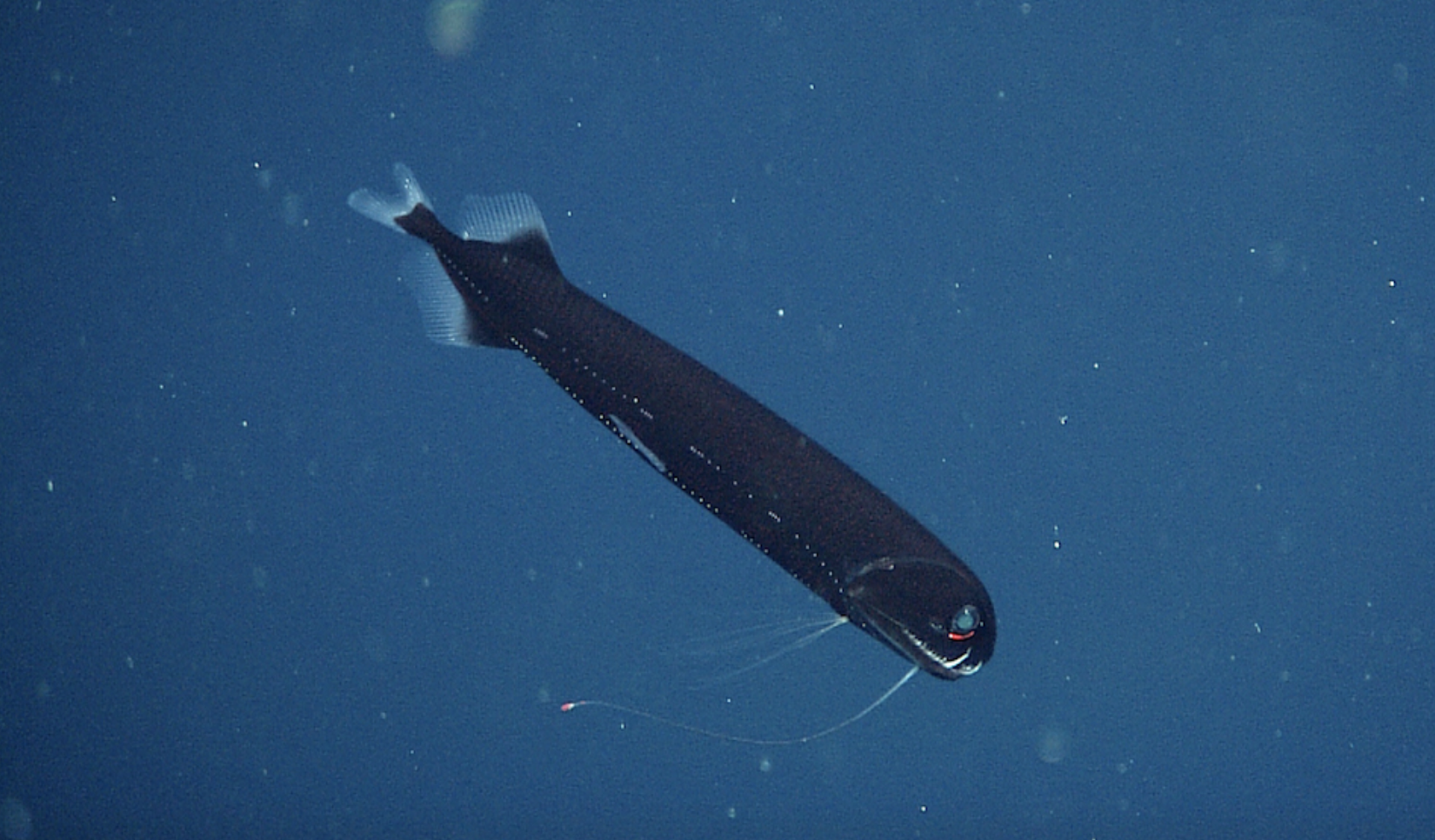

Il drago nero del Pacifico ( Idiacanthus antrostomus ). (© 2015 MBARI)

Il drago nero del Pacifico ( Idiacanthus antrostomus ). (© 2015 MBARI) La mascella mobile lucida ( Aristostomias scintillans ). (© 2007 MBARI)

La mascella mobile lucida ( Aristostomias scintillans ). (© 2007 MBARI) Il pesce drago dal ventre nero ( Stomias atriventer ). (© 2003 MBARI)

Il pesce drago dal ventre nero ( Stomias atriventer ). (© 2003 MBARI)