Abbiamo già parlato di oggetti definiti “Ooparts”, acronimo inglese per definire oggetti o manufatti non collegabili alla tecnologia ed alla cultura dell’epoca cui sembrano appartenere. Oggi prenderemo in esame il caso del disco di scisto.

Il disco è stato trovato a Sabu, nella tomba denominata 3111 e avvalendoci delle in formazioni prese sull’ottimo sito “Mistero risolto” scopriamo che la Tomba 3111 era circondata originariamente da una costruzione realizzata con mattoni di fango con pareti e nicchie che ne indicavano a Sabu uno status sociale molto elevato.

La facciata della prima Dinastia in origine era intonacata e dipinta di giallo per imitare il legno. Nell’angolo sud della sovrastruttura era posta una piattaforma di blocchi di calcare rozzamente lavorati.

L’archeologo W.B. Emery suggerisce che questo poteva indicare forse una struttura temporanea o e utilizzata nel corso delle cerimonie funebri di Sabu.

In una sala c’erano diversi frammenti di vasellame di pietra e ceramica oltre al famoso disco di scisto che presentava un foro centrale rialzato e tre aperture.

Il Disco ha un diametro di 61 centimetri e un’altezza massima di 10 centimetri. Il disco al momento del suo ritrovamento era schiacciato e rovinato ma è stato restaurato e ora fa bella mostra di sé al museo del Cairo.

L’oggetto, ha fatto pensare che fosse utilizzato per qualche forma di culto, infatti è realizzato in scisto, proprio come molti altri oggetti di culto. L’oggetto risale al 3000 aC, età in cui venne raggiunta la massima maestria nella lavorazione della pietra dura.

Questo oggetto discoidale, come detto, presentava un foro centrale probabilmente utilizzato per essere adattato a un palo di sostegno. William Kay, ingegnere inglese, ipotizzò che l’oggetto fosse una lampada a olio a tre fiamme utilizzata in qualche rito.

La lampada era dotata di un sistema di stoppini che comprendevano sei fasci di giunchi, legati insieme, tenuti in posizione dalla forma dei lati e così mantenuti immersi nell’olio, questa visione nasce soprattutto dal ritrovamento di simili strumenti rituali come il palo-lampada a petrolio trovato a Deir el Medina, ed esposto al museo del Cairo.

Fin qui nulla di anomalo, ma su questo disco in passato sono state raccontate non poche bufale.

Molti siti di informazione alternativa hanno affermato che il disco di scisto potesse essere il prodotto di una tecnologia non umana, nonostante la “scienza ufficiale” negasse tale possibilità, oppure che potesse essere il prodotto di avanzatissime tecnologie detenute dagli egiziani e che era parte di un’avanzato e sconosciuto dispositivo che non si sa bene cosa fosse in grado di fare, ma si sa i siti cospirazionisti devono assolutamente attirare l’attenzione con storie oltre il limite.

Altri affermarono che l’oggetto fosse di metallo, altri ancora che l’oggetto in scisto fosse solo una copia realizzata a partire dall’originale in metallo.

Insomma, come sempre i cospirazionisti ne sanno più degli scienziati.

L’oggetto, come sappiamo non è affatto in metallo esso è di metasiltite, una roccia sedimentaria chiamata siltite, però poiché trasformata in roccia metamorfica ma con il tratto dei caratteri originari del protolite ancora visibili, il prefisso meta viene aggiunto al nome di roccia. L’oggetto non era quindi nulla di speciale, tutt’altro, era un oggetto piuttosto comune se consideriamo gli oggetti rituali egiziani risalenti a 5000 anni fa, ci sono foto e esposizioni al Metropolitan Museum.

Come abbiamo ricordato, il disco di scisto non è certamente un oggetto unico, semplicemente dopo così tanto tempo non è facile trovarne altri.

Gli egizi erano abili artigiani e abilissimi nella lavorazione delle pietre dure, quindi, tutto quello che i fantarcheologi non capiscono e non conoscono non deve necessariamente essere un prodotto di una civiltà misteriosa e avanzatissima o lasciato sulla terra dagli extraterrestri.

Fonte: Mistero risolto

OOParts: Il disco di scisto

Self-interacting Dark Matter

Oggi parliamo di un modello di materia oscura al di là del paradigma LCDM (modello Lambda Cold Dark Matter) – il modello cosmologico standard – che non è ampiamente noto, ma ha attirato l’attenzione negli ultimi anni: Self-Interacting Dark Matter (SIDM), un tipo di materia oscura che, a differenza del CDM, risolve problemi in cosmologia. Su piccola e grande scala galattica, può correggere discrepanze tra osservazioni e previsioni del modello cosmologico standard, che invece considera la materia oscura “fredda” (CDM) che non interagisce con se stessa. E lo fa lasciando intatto il successo del modello standard su scale più grandi.

Manoj Kaplinghat dell’Università della California a Irvine, Hai-Bo Yu dell’Università della California a Riverside, e i colleghi hanno dimostrato che la materia oscura auto-interagente può anche spiegare la diversità delle curve di rotazione della galassia: grafici delle velocità delle stelle in una galassia rispetto alla loro distanza dal centro della galassia.

Le stelle e il gas nelle galassie di solito ruotano a una velocità costante al di sopra di una certa distanza dal centro della galassia: le curve di rotazione sono tutte essenzialmente ‘piatte’, non importa quanti “aloni” di materia oscura siano inglobati. Ma le galassie con aloni di materia oscura di massa simile possono avere curve molto diverse al di sotto di quella distanza: alcune curve si innalzano ripidamente verso il picco e altre gradualmente. Questa diversità è difficile da spiegare nel modello standard di materia oscura fredda.

Kaplinghat, Yu e colleghi hanno analizzato le curve di rotazione di 30 galassie che rappresentano bene questa diversità e hanno confrontato le curve con quelle derivate da un modello galattico che hanno sviluppato. Il modello include un alone di materia oscura auto-interagente nella regione interna e influisce sulla distribuzione della materia visibile nell’alone e sulla sua storia di formazione. I ricercatori hanno scoperto che il modello fornisce un’eccellente adattamento ai dati, fornendo supporto all’ipotesi che la materia oscura sia auto-interagente.

Questa ricerca è pubblicata in Physical Review Letters

https://physics.aps.org/synopsis-for/10.1103/PhysRevLett.119.111102

Nucleazione del vuoto di De Sitter

In uno studio pubblicato su Physics of the Dark Universe il 26 dicembre, Licata et al. propongono una nuova interpretazione nel framework Hartle-Hawking basato sull’olografia proiettiva De Sitter.

Lo stato di Hartle-Hawking (HH) o teoria dello stato senza confini, nell’ambito del modello standard, è una teoria fisica e un modello cosmologico sull’origine dell’universo ipotizzata da James Hartle e Stephen Hawking e, in seguito, con l’apporto anche di Thomas Hertog.

In questa teoria il Big Bang non deriva da una singolarità gravitazionale iniziale ma da uno “stato iniziale senza confini” descritto come una sorta di “cupola”.

L’universo – o meglio, uno stato primordiale a densità altissima di energia e temperatura, assai simile a un buco nero – sarebbe autosufficiente e auto-creato, mentre lo spaziotempo si sarebbe espanso ad un certo punto, per un evento come una fluttuazione da questo falso vuoto di tipo quantistico.

Lo stato di Hartle-Hawking si collocherebbe cronologicamente come periodo precedente all’era di Planck e all’inflazione. Esso è inoltre descritto come l’inizio dell’universo o del multiverso, oltre il quale non ha senso domandare cosa esistesse prima.

Il Big Bang sarebbe quindi una fase successiva a questo stato eterno precedente a tutto, essendo come un confine di una sfera, non si potrebbe viaggiare prima di esso, come non si può essere più a nord del polo terrestre.

La teoria venne elaborata per sopperire al problema della singolarità. Hawking rielaborò le leggi fisiche secondo una teoria matematica proposta da Richard Feynman (somma sulle storie o integrale sui cammini), introducendo così il “tempo immaginario“, un’astrazione matematica che permette di relazionare due eventi casualmente non connessi o non connessi temporalmente.

Con il tempo immaginario – ossia un tempo senza la presenza di spazio e spaziotempo – la singolarità può essere studiata. Hawking propone così un universo infinito o più precisamente senza contorno o confini, in espansione e con un inizio nel tempo immaginario. Tuttavia anche il modello ipotizzato da Hawking, è un modello che non può andare fino in fondo ed essere verificato fino a quando non si disporrà di una teoria che unifichi la gravità e la meccanica quantistica.

Nella teoria dello stato senza confini, la funzione d’onda dell’universo – ossia un’immagine per spiegare come sia nato l’universo – è calcolata attraverso l’integrale sui cammini (una funzione di tensione metrica definita a (D-1) di superficie compatta, dove D è la dimensione spazio-temporale). Questa funzione d’onda dell’universo può soddisfare l’equazione di Wheeler-DeWitt.

Il modello cosmologico prevede che l’universo non abbia confini nello spaziotempo, sostituendo il Big bang inteso come singolarità gravitazionale iniziale, con un modello matematico descritto per analogia con la regione di un polo terrestre.

Originariamente la nuova proposta prevedeva una forma dell’universo di tipo chiuso destinato a terminare in un Big Crunch o Big Bounce, ma le discussioni con Neil Turok hanno portato a concludere che la proposta di assenza di condizioni al contorno è valida anche nel caso di un universo aperto o piatto, la condizione al contorno dell’universo è che esso non ha un confine, è la descrizione del modello modificato da una sfera a una possibile cupola. Questo modello è basato sulla cosmologia quantistica e la gravità quantistica, ma utilizza una geometria complessa quadridimensionale, con un particolare oggetto detto istantone.

L’universo (o il multiverso) nascerebbe dal nulla come fluttuazione quantistica di particelle elementari, e all’inizio avrebbe avuto una forma a cupola o semi-sfera, al posto di una singolarità.

La teoria affronta la nascita dell’universo da una fluttuazione quantistica (cioè il Big Bang), ma la fine seguirà le altre teorie: un’inflazione infinita e nuovi universi, un “rimbalzo” o lo strappo del tessuto dello spaziotempo. L’universo dello stato di Hartle-Hawking non ha inizio, ma non è uguale alla teoria dello stato stazionario di Fred Hoyle (non è presente la cosiddetta creazione continua); esso semplicemente non ha confini iniziali, né di spazio né di tempo.

Questo modello vuole spiegare in particolare l’inizio di tutto, non la fine.

Il modello è adatto anche ad altre teorie sull’universo: in tal caso il vero stato di Hartle-Hawking non si colloca prima del Big Bang ma prima dell’ipotetica origine prima del multiverso e degli universi ciclici.

Nella nuova teoria di cui discuteremo in questo articolo, viene scelto di costruire la funzione d’onda a partire dal fattore di scala dell’Universo attraverso un approccio quantistico e, successivamente, viene mostrato che una tale funzione d’onda soddisfa la condizione senza confini di HH.

Considerando un puro Universo de Sitter, che semplifica la Cosmologia Lambda-CDM e modella l’Universo trascurando la materia ordinaria, le dinamiche dell’Universo sono dominate dalla costante cosmologica, che dovrebbe corrispondere all’Energia Oscura nell’Universo attuale. In questo caso, la prima equazione di Friedmann diventa l’operatore Hamiltoniano, che è esattamente l’Hamiltoniano di un semplice oscillatore armonico. Ottenere HH dall’equazione è coerente con l’idea della presenza di un effetto tunnel. Inoltre, si osserva che la frequenza dell’oscillatore dipende dalla costante cosmologica. Questo può suggerire un ruolo speciale di Λ, che va ben oltre la struttura geometrica su larga scala.

L’ interpretazione della meccanica quantistica (QM) in un quadro cosmologico richiede regole particolari. Un problema molto importante della QM, è che, con le sue varie interpretazioni, si riferisce a uno spazio-tempo in cui la funzione d’onda si evolve.

Al contrario, nella cosmologia quantistica la funzione d’onda genera lo spazio-tempo stesso.

In effetti, l’origine della cosmologia quantistica deriva essenzialmente dai tentativi di rimuovere la singolarità iniziale classica a livello quantistico e dà un punto di partenza per studiare il “tessuto sottile” della gravità quantistica.

La nostra funzione d’onda HH, in maniera suggestiva, si può descrivere come una “nebulosa quantistica” che sostituisce la singolarità iniziale classica. Questa “nebulosa quantistica” genera un’espansione accelerata della struttura spazio-temporale. Questo non deve essere considerato “un collasso”. Al contrario, è una sorta di transizione naturale e fluida che non ha precedenti in QM. Quindi, il compito principale della funzione d’onda HH è quello di produrre il collasso di un numero molto elevato di gradi di libertà di quanti, attraverso una sorta di “nucleazione”. In altre parole, lo spazio-tempo come fenomeno emergente.

L’oscillatore sembra una risposta naturale all’idea di nucleazione e ha una forte potenziale connessione con il valore della costante cosmologica che sembra essere una conseguenza logica dell’approccio di questo studio. Pertanto, i problemi riguardanti l’interpretazione fisica della funzione d’onda HH vengono trasferiti all’oscillatore che funziona con il tempo immaginario.

In realtà, questo problema era già apparso nella derivazione originale della funzione d’onda HH. La “nebulosa quantistica” è infatti tecnicamente descritta da Hartle & Hawking in termini di un universo simile a De Sitter che ha tempo immaginario.

In questo quadro, spazio e tempo sono indistinguibili e vicini l’uno all’altro.

Hawking e collaboratori hanno sottolineato in vari lavori che le successive sezioni parallele di quell’ipersfera dovrebbero rappresentare uno spazio ipersferico tridimensionale che parte da un “Polo Sud” non singolare. Questo polo si espande fino a raggiungere una dimensione massima e, successivamente, si riduce a un “Polo Nord”, che è ancora non singolare in quanto lo spazio globale ha un comportamento ipersferico. Questa idea è arrivata prima dell’evidenza cosmologica di un Universo in accelerazione con il ritorno trionfale della costante cosmologica, ma rappresenta l’essenza della linea di ragionamento di Hawking e collaboratori.

Il problema è che una tale linea di ragionamento sembra errata. Lo spazio-tempo di HH “prima” della nascita dell’Universo è ben definito e regolare, ma ha coordinata temporale immaginaria.

Quando “dopo” si passa allo spazio-tempo effettivo dell’universo neonato quest’ultimo è ancora ben definito e regolare, ma ora la coordinata temporale è reale.

Quindi, come passare da una situazione ben definita e regolare ad un altra ancora ben definita e regolare ma col tempo che da immaginario diventa reale?

Bisogna forzare qualche “collasso” o comunque qualche “evento esotico” che non sembra essere molto naturale. L’approccio di Licata et al. sembrerebbe un po’ più naturale di quello di HH.

Viene proposto un metodo alternativo per analizzare l’universo de Sitter, che si basa sull’approccio della cosiddetta relatività proiettiva de Sitter. Si pensa che in questo scenario la funzione d’onda HH e l’oscillatore possano trovare una nuova illuminante interpretazione.

Per il nostro scopo, è sufficiente definire il vuoto come un serbatoio di azione universale posizionato su una superficie 4D di un’ipersfera tridimensionale euclidea (5D). Questa superficie può essere convertita in un iperboloide 4D che rappresenta uno spazio-tempo de Sitter mediante una rotazione di Wick (metodo per trovare soluzioni matematiche a un problema nello spazio di Minkowski, risolvendolo nel corrispondente spazio euclideo. Ciò avviene operando una trasformazione che sostituisce le variabili immaginarie con variabili reali, operazione nota in matematica come prolungamento analitico).

La rappresentazione proiettiva di Beltrami di questo spazio-tempo de Sitter su un iperpiano 4D tangente all’iperboloide nel punto-evento dell’osservazione è nota come “cronografo di Castelnuovo“. È importante notare che questo approccio rende possibile individuare l’Universo de Sitter come un quadro di processi fisici senza fare riferimento ad alcuna fisica “locale”.

Le posizioni spazio-temporali di eventi osservabili non appartengono alla fase arcaica rappresentata nell’ipersfera: essa è popolata solo di processi virtuali. Abbiamo chiamato tale teoria “arcaica” perché il ruolo dell’ipersfera e quello dell’Universo osservato non sono correlati da un “prima” e un “dopo“. L’ipersfera è piuttosto come una fase a-temporale altamente non locale.

Le posizioni spazio-temporali o “etichette” sono invece correlate alle descrizioni delle classi di osservatori sul piano P4 tangente (rappresentazione proiettiva Beltrami-Castelnuovo, vedi figura 4.1). Il passaggio da una descrizione all’altra è definito dalla rotazione di Wick : prima di saltare fuori dal vuoto, le particelle sono in uno stato virtuale descritto dal tempo immaginario del pre-spazio; durante il ritardo dell’esistenza osservabile, entra in gioco il tempo reale. La manifestazione di particelle dal vuoto e la loro scomparsa nel vuoto sono le vere micro-interazioni descritte nella teoria quantistica attraverso il “collasso” o la riduzione della funzione d’onda (processi R). A tutti gli effetti: una “localizzazione” a livello di singolo evento in microfisica, una “nucleazione” nel caso del Big Bang.

Ora diamo un’occhiata più da vicino al ruolo del tempo immaginario.

Possiamo pensare a un asse x0 dell’ipersfera che rappresenta le temperature inverse e immaginare che sotto un valore critico di questa coordinata i processi fisici siano costretti a rimanere virtuali. Questo vincolo viene rimosso quando x0 supera il valore critico, permettendo così l’emergere di processi reali in tempo reale, ad una velocità completamente analoga a quella esponenziale del decadimento radioattivo.

Questo asse può essere considerato come un “precursore arcaico” del tempo. La sfera-5D è:

(x0)^2 + (x1)^2 + (x2)^2 + (x3)^2 + (x5)^2 = r^2 (1)

È ragionevole supporre che il valore critico corrisponda alla temperatura della bariogenesi: TC = ~ kθ0 (2) dove θ0 ∼ 10^−23 s svolgendo il ruolo dell’intervallo di tempo fondamentale (cronone), quindi TC ≈ 10^13 K. L’espansione dello spazio è descritta dall’estensione canonica della (1), ovvero:

(x0)^ 2 −R^2 (τ) [(x1)^2 (x2)^2 (x3)^2] (x5)^2 = r^2 (3) dove τ è il tempo cosmico.

Una differenza importante rispetto alla cosmologia di Friedmann è che, pur ammettendo una molteplicità di possibili modelli, che saranno successivamente selezionati in base all’osservazione, l’approccio qui descritto porta a un singolo modello cosmologico.

Corrisponde al modello di Friedmann con curvatura spaziale nulla (k = 0) e un termine cosmologico positivo λ. Fissando la costante cosmologica, si trova anche una nuova costante naturale t0, che ha le dimensioni del tempo; questo tempo è correlato al raggio r de Sitter attraverso la relazione r = ct0, dove c è la velocità della luce nel vuoto.

Se si assume che l’inizio dell’espansione coincida con l’origine di x0, ovvero che il Big Bang si verifichi sull’equatore x0 = 0 dell’ipersfera (1), si ottiene il valore ± r per la variabile x5. In termini geometrici, ciò corrisponde a un Big Bang a forma di punto associato a un punto sull’equatore della sfera-5D. Tuttavia, l’asse x5 può essere ruotato su questo equatore dando origine a differenti (ed equivalenti) intersezioni.

Pertanto, si hanno differenti (ed equivalenti) Big Bang o, per essere più precisi, differenti (ed equivalenti) punti di vista dello stesso Big Bang, che sono pertinenti a osservatori fondamentali (inerziali) distinti. Nelle coordinate dei singoli osservatori, la metrica è coerente con l’equazione (3) e quindi tutti gli osservatori vedono un Universo in espansione. Ad un certo valore del tempo cosmico τ, tutti gli osservatori vedono l’Universo nelle stesse condizioni.

Pertanto, il principio cosmologico funziona a condizione che la materia sull’equatore x0 = 0 sia omogenea. Il vuoto senza dimensioni a partire dal quale si sviluppa il Big Bang è quindi sostituito, in questo approccio, da uno spazio preesistente: l’equatore della sfera-5D (1). Il passaggio dalla condizione (1) alla condizione (3) avviene a un valore critico θ0 della variabile x0 / c. Per quel valore critico, diventano possibili processi di localizzazione quantistica di particelle elementari nello spazio-tempo. L’emergere di tutte le particelle elementari nel dominio spazio-temporale è la vera essenza del Big Bang.

A partire da questa nucleazione dal vuoto di una sfera-5D, la propagazione delle particelle è descritta da funzioni d’onda in cui le coordinate che soddisfano la condizione (3) e non più la condizione (1). La “fase arcaica” governata dalla condizione (1) termina e inizia la storia effettiva dell’Universo governata dalla condizione (3) dell’espansione dello spazio. E il tempo “scorre”.

Va notato che la contrazione risultante dalla distanza della scala opera sullo ‘spazio-tempo privato‘ dei singoli osservatori fondamentali, non sullo ‘spazio-tempo pubblico‘, che rimane invariato.Quando ci si avvicina al Big Bang procedendo all’indietro nel tempo cosmico, lo spazio di contemporaneità privata di ciascun osservatore si contrae in un punto; ma lo spazio pubblico non contratto sarà identico per tutti gli osservatori. Pertanto, non esiste mai un valore di densità singolare.

In altre parole, nello spazio pubblico, il Big Bang non è veramente una singolarità. Pertanto, l’origine dell’Universo (e del tempo) è un processo di nucleazione che implica un passaggio dall’informazione all’energia. Data l’omogeneità iniziale, tutti gli osservatori fondamentali vedranno le stesse condizioni cosmiche fisiche, nonostante l’assenza di correlazioni causali tra le loro rispettive posizioni. In questo modo vengono ignorate due difficoltà del modello standard, vale a dire la giustificazione dell’omogeneità iniziale (che è qui l’aspetto naturale di un pre-vuoto) e l’apparizione di una singolarità. L’isotropia spazio-temporale e l’omogeneità sono le conseguenze del decadimento di un (pre) vuoto arcaico isotropico e omogeneo; questa linea di ragionamento concorda con alcune caratteristiche importanti di altri approcci contemporanei. Questa soluzione è molto simile a quella dell’Universo di Hartle-Hawking senza confini, ma anche a quella proposta da Bohm et al. per i processi di “localizzazione spontanea”

Ora torniamo alla funzione d’onda HH e all’oscillatore. Si sostiene infatti che il significato formale e fisico dell’oscillatore che funziona con il tempo immaginario può essere chiarito nel quadro dell’olografia de Sitter.

Si presume che l’ipersfera S4 sia una forma geometrica del vuoto quantistico, che a sua volta è considerata un serbatoio di informazioni universale o, in termini più fisici, popolata solo da processi virtuali (tempo immaginario). Questo modello giocattolo del vuoto quantistico è stato etichettato come “universo arcaico” perché la sua relazione con gli osservabili non è cronologica.

È invece logica.

In effetti, la relazione tra S4 e lo scenario post big bang standard, che funziona in tempo reale e riguarda un’espansione accelerata dell’Universo, si ottiene attraverso la rotazione di Wick e la proiezione di Beltrami-Castelnuovo su un piano tangente all’ipersfera P4 (vedi fig. 4.1 e 5.1) Si nota che ogni gruppo P4 “eredita” da S4 lo stesso evento, e quindi definisce un substrato uguale per tutti gli osservatori. Qui l’eterno di De Sitter è solo l’ipersfera S4, mentre le quantità che lavorano in tempo reale e si riferiscono a osservabili sono attribuite a P4. Non ci sono né singolarità fisiche (ma solo apparenti dovute all’orizzonte degli eventi) né contraddizioni (forzature) nella transizione tra le due diverse geometrie. Il quadro più naturale per l’oscillatore quantistico dovrebbe essere la superficie di S4.

A causa dell’assenza di tempo, questa superficie agisce come una specie di membrana non locale. Una delle coordinate di S4 ha il ruolo di un precursore arcaico del tempo e, a causa della temperatura critica (2), inizia a nucleare.

In altre parole, la popolazione virtuale inizia a mostrarsi in termini di materia reale. Sosteniamo che questa dovrebbe essere l’essenza fisica del “big bang” e sembra che questo tipo di descrizione non sia troppo distante da una descrizione tradizionale.

In termini relativistici tradizionali, si può dire che l’ipersfera rappresenta una condizione di confine globale riguardante un big bang con una “singolarità isotropica”. Questo è esattamente ciò che è richiesto dall’equazione di Wheeler – de Witt. Il prezzo da pagare – che qui sembra essere favorevole – è una diversa interpretazione della funzione d’onda cosmologica in termini di prodotto delle funzioni d’onda delle particelle nucleate. L’importante differenza è che la connessione tra le due fasi non è dinamica come nel lavoro originale di Hartle e Hawking, è invece olografica attraverso la trasformazione di Wick e la proiezione de Sitter.

In pratica, si sostiene che il vuoto arcaico dà forma al vuoto quantistico attraverso le condizioni al contorno mentre l’evoluzione dell’Universo rappresenta la sua proiezione.

L’approccio basato sugli eventi (che unisce cosmologia e microfisica ed è connessa con i popolari approcci “senza tempo”) rappresenta un’estensione della QM standard, basato su una scala temporale per la localizzazione.

Il significato del cronone non deve essere considerato come un “tempo minimo“, ma come una scala temporale compatibile con la localizzazione di oggetti barionici, cioè una sorta di raggio classico analogo al raggio classico dell’elettrone di Bohr. Questo è ciò che ci si aspetta da un approccio semi-classico HH che è molto distante dalla scala di gravità quantistica di Planck.

Nel quadro della relatività di De Sitter si trova l’orizzonte cosmologico di De Sitter: si presume che la localizzazione di un processo R sia associata alla formazione di un micro-orizzonte de Sitter in accordo con la funzione d’onda che sta entrando / uscendo da il processo; la costante è indipendente dal tempo cosmico, pertanto, anche il rapporto che ne risulta è indipendente dal tempo cosmico; questo rapporto esprime il numero di localizzazioni temporali distinte che sono accessibili dal processo R all’interno dell’orizzonte cosmologico di De Sitter.

Questo è un tipo di informazione che è codificata sull’asse del tempo all’interno dell’orizzonte di Sitter dell’osservatore. I processi R sono in effetti interazioni reali tra particelle reali. Durante tali interazioni viene scambiata una quantità di azione dell’ordine della costante di Planck h. Le informazioni sulla localizzazione dei processi R dovrebbero essere collegate all’entropia attraverso il principio di indeterminazione. Pertanto, sembra naturale chiedersi se si possa applicare il limite di Bekenstein sull’entropia, in qualche modo, ai due orizzonti citati.

Supponendo che le informazioni sulla localizzazione temporale dei processi R siano collegate all’area del micro-orizzonte e di conseguenza dalla relazione olografica si ricava che l’estensione spaziale di un bit di informazioni risulta essere l ≈ 10^−33 cm, questa è la lunghezza di Planck!

Si ottiene così una relazione globale-locale, che è esattamente ciò che ci si aspetta da una teoria del vuoto interpretata in termini di serbatoio universale di informazioni.

In questo articolo, si fa riferimento alla connessione tra la frequenza dell’oscillatore e la costante cosmologica. Da questa discussione, si può ragionevolmente sostenere che la congettura olografica dovrebbe essere una proprietà dei due orizzonti simili al tempo: l’orizzonte cosmologico (t0) e l’orizzonte “simile a una particella” (θ0).

Questa congettura olografica non può essere generalizzata ad altri sistemi fisici (con l’esclusione dei buchi neri, perché i buchi neri hanno il proprio orizzonte degli eventi).

L’informazione associata alla localizzazione temporale di un evento fisico (processo R) ha un comportamento preciso. Lo stesso accade per la sua localizzazione spaziale. Questo perché un osservatore vede l’estensione di una transizione nel tempo di Beltrami come avente un limite inferiore dovuto all’orizzonte “simile a una particella” e un limite superiore dovuto all’orizzonte cosmologico.

Ciò suggerisce un’interpretazione interessante della costante cosmologica in termini di “indice di diffusione delle informazioni“. Inoltre, la vecchia questione sulla natura della costante cosmologica in termini di geometria contro fisica, qui è aggirata dall’interpretazione simile a Milne. Da un lato, in S4 Λ appare come un ingrediente puramente geometrico, pertinente alla struttura dello spazio de Sitter. D’altra parte, in P4, dopo il processo di nucleazione e la conversione dall’informazione alla materia, è sia lecito che necessario interpretare la costante cosmologica in termini di campi e particelle, in particolare per quanto riguarda le questioni aperte sul campo di Higgs e Dark Matter.

L’analisi in questo documento è limitata a un approccio semi-classico. Invece, il processo di nucleazione dovrebbe implicare l’emergere sia dello spazio che del tempo da una rete di eventi elementari. L’olografia proiettiva può introdurre una certa chiarezza nel dibattito attuale, consentendo una chiara distinzione tra S4 e P4. In quella direzione potrebbe essere possibile una migliore comprensione degli approcci olografici più tradizionali collegati alla congettura di Maldacena, in particolare attraverso l’avvento di una nuova centralità dello spazio-tempo di De Sitter rispetto allo spazio-tempo di Anti-de Sitter.

In effetti, uno dei problemi più importanti in questo campo di ricerca consiste nel proiettare un ologramma da una particella quantistica che vive nel futuro infinito. Ciò ha fortemente ostacolato vari aspetti al fine di descrivere in termini olografici il vero spazio-tempo.

È possibile analizzare questo problema in un framework S4 / P4 al fine di ottenere una formulazione più luminosa, che sembra più praticabile dopo il risultato edificante [Dong et al. 2018] che ha trasformato due spazi Anti-de Sitter a forma di sella in spazi de Sitter aventi forma di ciotola.

Infine, per completezza, segnaliamo anche la recente ipotesi cosmologica CPT in [Boyle et al. 2018], che deriva dal problema che la struttura S4 suggerisce due mondi speculari (molto probabilmente spazi Anti-de Sitter). L’olografia proiettiva De Sitter mostra una struttura che è naturalmente olografica, in cui il pre-spazio 5D funziona come uno schermo e le sue proiezioni sul piano tangenziale P4 rappresentano la massa, cioè l’espressione del mondo fisico reale. Nell’olografia arcaica, i processi di localizzazione e delocalizzazione sembrano aspetti complementari del mondo, mentre il principio di indeterminazione rappresenta una “porta” tra due diversi livelli di descrizioni fisiche: dalla fisica delle particelle alla cosmologia. Entrambi sono fortemente unificati in una connessione globale-locale.

Le relazioni tra varie quantità fisiche come la costante cosmologica, i crononi e la lunghezza di Planck sono fortemente interconnesse e, a livello globale, indicano il comportamento finito delle informazioni in Natura.

[Hartle-Hawking boundary conditions as Nucleation by de Sitter Vacuum – Feleppa, Licata, Corda, 2019] https://doi.org/10.1016/j.dark.2019.100381

Chi siamo, da dove veniamo, quando è iniziato il nostro lungo viaggio?

Le teorie precedenti sulla genesi, lo sviluppo e la successiva migrazione della nostra specie ci dicevano che noi Sapiens ci siamo evoluti in Africa orientale qualcosa come 200 mila anni fa. I successivi 140 mila anni avrebbero visto la nostra specie permanere in quei territori prima della grande avventura della conquista dell’Europa e dell’Asia avvenuta 60 mila anni fa, conquistando territori un tempo appartenuti ad altre specie umane, i Neanderthal.

Nuove scoperte hanno sovvertito questa linea di pensiero, oggi si ritiene che la specie homo sapiens sia più vecchia di quanto si pensava e invece di aver semplicemente preso il posto di altre specie si sia incrociata con loro.

A retrodatare l’origine dell’homo sapiens una scoperta risalente al 2017 avvenuta in Marocco, dove le ossa ritrovate nella regione del Jebel Irhoud sono state datate a circa 315 mila anni fa, ben 100 mila anni più vecchie delle ossa precedentemente ritrovate e ritenute i più antichi fossili umani moderni. I fossili provengono da un’area dell’Africa diversa rispetto ai fossili ritrovati precedentemente, l’Africa orientale. Questo significa che probabilmente l’homo sapiens non si è sviluppato in una perte specifica del continente africano.

Nel 2018 un gruppo di ricercatori ha proposto un’idea, quella che gruppi di sapiens si sarebbero evoluti in Africa simultaneamente in zone differenti. I gruppi, inizialmente differenti tra loro ma geneticamente vicini potevano essere considerati homo sapiens.

Nel 2019, in ottobre, una ricerca ha suggerito la possibilità che gli uomini moderni discendano da una donna vissuta circa 200 mila anni fa nel territorio che oggi conosciamo come Botswana. A confermarlo sarebbe l’analisi del DNA dei resti della donna. La scoperta appoggia la teoria che vuole i nostri antenati migrare dall’Africa per colonizzare il resto del mondo anziché evolversi in diverse zone del pianeta.

In genere, il DNA antico viene estratto dalle ossa. Nel dicembre scorso tuttavia è stato sequenziato un DNA estratto da un pezzo di gomma da masticare fatta di betulla risalente a 5700 anni fa. Si è scoperto che a masticare l’antica gomma fu una donna con pelle scura, capelli scuri e occhi blu.

Il genoma dei Neanderthal invece è stato sequenziato del tutto nel 2010 e i genetisti hanno fatto una scoperta che cambia molte cose, i Neanderthal si incrociarono più volte con gli homo sapiens ribaltando l’idea del loro sterminio da parte degli stessi sapiens.

Secondo uno studio del 2018, un’altra specie appartenente al ramo dei Neanderthal chiamata Denisovan, scomparsa circa 50 mila anni fa, si sarebbe incrociata con l’homo sapiens. Il DNA dei Denisovani si trova nel 5% del genoma degli uomini moderni in Asia e nel Pacifico. Resti dei Denisovani sono stati rinvenuti nel marzo 2010 in Russia e in Tibet.

Un’altra specie venne rinvenuta nell’aprile 2010 e fu chiamata Australopithecus sediba, a Malapa, in Sudafrica.

Questa specie aveva denti e arti inferiori che ricordavano quelli del nostro genere Homo. Le gambe e i piedi di questi antenati erano adattati a camminare in posizione eretta.

I fossili di Homo naledi invece vennero ritrovati in una grotta nascosta. La grotta conteneva 1.550 ossa appartenenti ad almeno 15 individui vissuti tra 330.000 e 250.000 anni fa. La cronologia suggerisce che questo antenato umano potrebbe essere vissuto accanto al primo Homo sapiens in Africa.

Un’ulteriore specie chiamata Homo luzonensis, dal nome dell’isola, visse tra i 50 mila e i 67 mila anni or sono. Condivideva tratti con antenati più vecchi come l’Australopithecus e l’Homo erectus, così come con gli umani moderni.

Secondo uno studio del 2017, l’Homo sapiens iniziò il processo di migrazione già 120 mila anni fa, molto prima dei 60 mila anni ipotizzati in precedenza.

A partire dall’Africa, prima di 60 mila anni fa, erano forse piccoli gruppi di raccoglitori che hanno lasciato poche tracce genetiche nell’uomo moderno. Questo piccolo evento, secondo l’autore dello studio, Michael Petraglia, è stato seguito da un grande evento verificatosi 60 mila ani fa o poco dopo, che portò la diffusione dell’homo sapiens in Europa, Asia e Pacifico.

Un teschio risalente a 210 mila anni fa, trovato in Grecia, sposta ancora di più nel nostro passato le migrazioni. Esso appartiene al più antico essere umano moderno scoperto fuori dall’Africa. Precede ciò che i ricercatori hanno precedentemente considerato la prima prova dell’Homo sapiens in Europa datata tra i 42 e i 45 mila anni fa.

Questi resti vennero rinvenuti in Italia e nel Regno unito, una mascella rinvenuta in Israele invece è stata datata 177 mila anni aggiungendo un importante tassello alla teoria che l’Homo sapiens migrò dall’Africa molte decine di migliaia di anni prima di quanto ritenuto.

Fonte: Business Insider

Le donne-computer della NASA

Per molti anni, dal 1943 a gran parte degli anni Cinquanta, la NACA che dal 29 luglio 1958 diverrà la NASA, utilizzò dei computer umani per lo sviluppo del programma spaziale. Si trattava in gran parte di donne di colore che facevano e rifacevano calcoli di ogni tipo in modo che fisici, matematici ed ingegneri potessero dedicarsi ad altro, ottimizzando i tempi di lavoro.

Tre donne in particolare negli anni Sessanta diedero un prezioso contributo alla corsa allo spazio americana: Katherine Johnson, Mary Jackson e Dorothy Vaughan.

Mary Jackson fu la prima donna ingegnere della NASA. Katherine Johnson che aveva completato gli studi al college all’età di 18 anni, si occupò dei calcoli per le traiettorie, le finestre di lancio e le rotte di ritorno per i primi voli spaziali statunitensi con esseri umani a bordo. Tra questi ricordiamo quello di Alan Shepard e la missione Atlas-Mercury 6. Katherine lavorò anche alle traiettorie della missione Apollo 11 ed ai calcoli per le procedure di emergenza di Apollo 13.

Il suo straordinario apporto sarà riconosciuto e premiato con la Medaglia della Libertà (la massima onorificenza civile americana) nel 2015 dall’allora Presidente Barack Obama.

Dorothy Vaughan fu invece la prima donna di colore che dal 1948 svolse ruolo di supervisore nell’allora NACA. Con l’avvento dei primi computer elettronici Dorothy divenne una grande esperta del linguaggio di programmazione FORTRAN che insegnò alle decine di donne-computer che coordinava.

Le storie di queste straordinarie donne sono raccontate nel film “Il diritto di contare”, 2016, per la regia di Theodore Melfi. Il film racconta la storia vera della matematica, scienziata e fisica afroamericana Katherine Johnson, che collaborò con la NASA, sfidando razzismo e sessismo, tracciando le traiettorie per il Programma Mercury e la missione Apollo 11.

Ma torniamo ai computer. I primi esemplari erano di dimensioni enormi e del tutto inadatti ad essere trasportati su una navicella spaziale. Ancora una volta un ruolo fondamentale lo svolgerà un’altra donna: la matematica Margaret Heafield Hamilton (Paoli, Indiana, 17 agosto 1936).

Nel 1960 Margaret ottiene un impiego temporaneo al Massachusetts Institute of Technology (MIT) per sviluppare software per le previsioni meteo per i calcolatori LGP-30 e PDP-1 per un progetto del professor Edward Norton Lorenz, del dipartimento di meteorologia. Il progetto verrà poi esteso per fini militari e prenderà il nome di SAGE, Semi Automatic Ground Environment.

La Hamilton scrisse in seguito a questa sua esperienza: «Quello che erano soliti fare quando entravi, senza esperienza, in questa organizzazione, era di assegnarti un programma che nessuno era in grado nemmeno di capire come far funzionare. Quando ero alle prime armi lo diedero anche a me, e quel che successe è che si trattava di un programma pieno d’insidie e la persona che lo aveva realizzato si era divertito a commentare il codice in greco e in latino. Così, fui assegnata a questo programma e riuscii a farlo funzionare. Addirittura riportava l’output in greco e latino. Fui la prima a riuscire a farlo funzionare» .

Grazie comunque a questo successo Margaret ottiene il posto di capo sviluppo per il software di volo del programma Apollo alla NASA, presso il Charles Stark Draper Laboratory del MIT. Ed è proprio al MIT che viene progettato l’APOLLO GUIDANCE COMPUTER (AGC), il computer delle navicelle spaziali delle missioni Apollo.

Si trattava per l’epoca di un computer di dimensioni ridotte, era grande come una lavatrice ed in grado di operare in multitasking essendo in grado di eseguire fino ad otto programmi contemporaneamente. Fu anche il primo computer ad usare i circuiti integrati. Insomma si trattava del top della tecnologia dell’epoca. Questa meraviglia della tecnica però fu così ridimensionata diversi anni dopo da Charles Duke (Apollo 16) uno dei 12 uomini che hanno calpestato il suolo lunare: “Il computer del nostro modulo lunare aveva una potenza di calcolo migliaia di volte inferiore al Blackberry che ho in tasca”.

L’AGC era infatti basato su un’unità con frequenza di calcolo che al massimo poteva raggiungere i 2 Megahertz, gli attuali smartphone hanno una potenza di calcolo che supera i 2.000 Megahertz. La memoria RAM poteva ospitare 2.000 parole, quella ROM circa 30.000. Un file Word medio occuperebbe tutta la memoria del computer di bordo delle navicelle usate per le missioni Apollo.

Nonostante questo e grazie anche allo straordinario contributo di decine di donne talvolta misconosciute l’uomo è riuscito nell’impresa esplorativa più spettacolare della sua storia.

Aggiornamento 24/02/20202: Si è spenta a 101 anni Katherine Johnson. Lo ha annunciato in un tweet la Nasa, l’agenzia spaziale Usa per la quale la Johnson lavorò come matematica per 33 anni, fornendo un contributo fondamentale, tra l’altro, alla missione Apollo 11, che portò il primo uomo sulla Luna.

Per la prima volta osservate gruppo di galassie responsabile della re-ionizzazione cosmica

Un team internazionale di astronomi finanziato in parte dalla NASA ha trovato il gruppo di galassie più lontano finora identificato. Chiamato EGS77, il trio di galassie risale a un tempo in cui l’universo aveva solo 680 milioni di anni, o meno del 5% della sua età attuale di 13,8 miliardi di anni. Questa è la prima osservazione di un gruppo di galassie responsabile della re-ionizzazione cosmica.

“Il giovane universo era pieno di atomi di idrogeno, che attenuavano così tanto la luce ultravioletta da bloccare la nostra visione delle prime galassie“, ha detto James Rhoads al Goddard Space Flight Center della NASA a Greenbelt, Maryland, dove ha presentato i risultati il 5 gennaio al 235 incontro della American Astronomical Society a Honolulu. “EGS77 è il primo gruppo di galassie catturato nell’atto di eliminare questa nebbia cosmica“.

Nella sua prima fase, l’universo era un plasma incandescente di particelle, inclusi elettroni, protoni, nuclei atomici e luce. Gli atomi non potevano ancora esistere. L’universo era in uno stato ionizzato, simile al gas all’interno di un’insegna al neon illuminata o di un tubo fluorescente. Dopo che l’universo si è espanso e raffreddato per circa 380.000 anni, elettroni e protoni si sono combinati nei primi atomi, più del 90% dei quali erano di idrogeno. Centinaia di milioni di anni dopo, questo gas formò le prime stelle e galassie. Ma la presenza stessa di questo abbondante gas pone sfide per individuare le galassie nell’universo primordiale.

Si pensa che le galassie stellari ad alto spostamento verso il rosso abbiano contribuito al processo di re-ionizzazione. Queste stesse galassie, tramite la loro emissione Lyman-α, forniscono uno strumento pratico per studiare il processo di re-ionizzazione – l’evoluzione dell’idrogeno neutro nell’IGM.

Attualmente comunque, ci manca una chiara evidenza osservativa della disomogeneità spaziale o delle sorgenti responsabili della re-ionizzazione cosmica. Pertanto, per studiare la sua natura e quantificare il contributo delle galassie a questo processo, è stata condotta un’esclusiva indagine di imaging a banda stretta (NB), la Cosmic Deep And Wide Narrowband sondaggio (DAWN; PI: Rhoads) per osservare le galassie che emettono Lyman- α ad redshift.

Nel documento, guidato da Tilvi che è stato presentato al The Astrophysical Journal, si riporta la scoperta del gruppo di galassie più lontano EGS77 a z = 7,7, appena 680 Milioni di anni dopo il Big Bang.

EGS77 è stato inizialmente identificato utilizzando le osservazioni di imaging NB dal sondaggio DAWN, e successivamente confermato tramite osservazioni spettroscopiche utilizzando lo spettrografo MOSFIRE sul telescopio Keck.

In base al modello e alle simulazioni in letteratura, il team ha scoperto che le bolle ionizzate prodotte da tutte e tre le galassie si sovrappongono in modo significativo, producendo una regione ionizzata grande, ma localizzata, che dà origine alla disomogeneità attesa nel processo di re-ionizzazione.

Quindi, questa è la prima osservazione di un gruppo di galassie responsabile della re-ionizzazione cosmica. Il telescopio spaziale James Webb sarà sensibile al continuum UV di tali galassie più deboli nell’epoca della reionizzazione e quindi potrà fornire un campione molto più ampio delle galassie responsabili di tale processo. Inoltre, future osservazioni di 21 cm da SKA-2 (Dewdney et al. 2009) saranno in grado di sondare le strutture ionizzate con dimensioni angolari grandi fino a ∼ 100, simili alle dimensioni della bolla ionizzata prodotta da z8_5 a z = 7,7.

[Onset of Cosmic Reionization: Evidence of An Ionized Bubble Merely 680 Myrs after

the Big Bang – Tilvi et al. 2020]

Fonte: NASA

Vuoti cosmici sotto pressione

Le galassie tendono ad essere i protagonisti dell’astronomia. Ma i ricercatori stanno scoprendo che c’è molto da imparare dallo studio dei vuoti cosmici: zone di spazio per lo più vuoto, di centinaia di milioni di anni luce di diametro. La temperatura e la pressione del gas nei vuoti potrebbero, ad esempio, fornire indizi su come l’energia attraversa il cosmo.

David Alonso, dell’Università di Oxford nel Regno Unito, e colleghi hanno compiuto uno dei primi passi per determinare queste proprietà del analizzando come il gas distorce la luce dall’universo primordiale.

Il fondo cosmico a microonde (CMB) è la prima luce emessa nel cosmo, circa 380.000 anni dopo il big bang. Il gas intergalattico aumenta l’energia dei fotoni dal CMB e questa distorsione è una potente sonda del gas negli ammassi di galassie. Ma nessuno lo ha ancora usato per studiare i vuoti.

Il team di Alonso ha combinato le mappe della CMB con le immagini di 774 vuoti cosmici. I ricercatori hanno quindi dedotto le proprietà del gas all’interno di ciascun vuoto confrontando l’energia misurata dei fotoni CMB con i modelli della pressione elettronica nei vuoti.

Hanno scoperto che la pressione nei vuoti è più bassa della media cosmica. Questo risultato non è sorprendente dato che accade poco nei vuoti e può significare che i vuoti si sono appena evoluti passivamente nell’età dell’Universo. Ma alcuni dati suggeriscono che il gas potrebbe essere più caldo del previsto. Se questa scoperta reggerà al controllo, potrebbe essere un segno che potenti getti dai buchi neri supermassicci stanno pompando energia nel gas intergalattico e contribuendo a modellare il cosmo.

La risoluzione di questo problema dovrà attendere diversi anni per telescopi più potenti come l’Osservatorio Simons in Cile.

Questa ricerca è pubblicata in Physical Review D.

https://physics.aps.org/synopsis-for/10.1103/PhysRevD.97.063514

Cosa succede dentro gli atomi?

Cosa sappiamo degli atomi?

Un atomo è composto da un nucleo e dagli elettroni che che vi orbitano intorno nel guscio esterno. Essenzialmente, però, un atomo è costituito da spazio vuoto con la maggior parte della massa concentrata nel nucleo, composto da protoni e neutroni, o da un solo protone, nel caso dell’atomo più semplice, quello di idrogeno.

I protoni hanno una carica elettrica definita positiva, i neutroni sono privi di carica e formano il nucleo tenuti incollati dalla forza forte. Il numero dei protoni determina il tipo di atomo in base al numero, se è un atomo stabile o se emette altre particelle. Nessuno però sa come si comportano i nucleoni, cioè i protoni e i neutroni presenti nel nucleo atomico.

Sia i protoni che i neutroni sono stati misurati all’esterno di un nucleo e si è scoperto che sia gli uni che gli altri sono composti da altre particelle, i quark, tre quark ciascuno. Le interazioni tra i quark, che per quanto ne sappiamo dovrebbero essere particelle fondamentali, cioè non scomponibili ulteriormente, sono cosi intense che nessuna forza può deformarli.

Alcuni esperimenti hanno dimostrato che, all’interno di un nucleo, protoni e neutroni appaiono molto più grandi di quanto dovrebbero essere e per spiegare questa differenza oggi abbiamo a disposizione due teorie.

Sappiamo dagli anni ’40, che i nucleoni si muovono in piccoli orbitali all’interno del nucleo, I nucleoni, confinati nei loro movimenti, hanno pochissima energia frenati dalla forza forte.

Nel 1983 venne effettuato un esperimento al CERN, e i fisici si accorsero che un fascio di elettroni venivano deflessi in modo diverso quando colpivano protoni liberi. Eppure si riteneva che i protoni fossero tutti uguali ma, per qualche motivo, i protoni ed i neutroni che costituiscono i nucleoni sembrano avere dimensioni maggiori. L’effetto viene chiamato EMC (European Muon Collaboration, dal nome del gruppo che l’ha scoperto per puro caso). Questo effetto viola le teorie esistenti della fisica nucleare.

Secondo Hen, un fisico nucleare del MIT, il fenomeno potrebbe essere spiegato pensando che i quark che compongono i nucleoni, interagiscono intensamente all’interno di un dato protone o neutrone, i quark in protoni e neutroni liberi non possono interagire molto tra loro. La forza forte all’interno di un nucleo è così forte da eclissare la forza forte che trattiene i nucleoni ad altri nucleoni.

Tuttavia, recenti esperimenti hanno dimostrato che in un dato momento, circa il 20% dei nucleoni in un nucleo sono in realtà al di fuori dei loro orbitali, accoppiati con altri nucleoni, interagendo in “correlazioni a corto raggio“. In questo modo le interazioni tra i nucleoni sono di energia molto più elevata perché i quark penetrano attraverso le pareti dei loro singoli nucleoni e iniziano a interagire direttamente, e le interazioni quark-quark sono molto più potenti delle interazioni nucleone-nucleone.

Queste interazioni abbattono le pareti che separano i quark all’interno dei singoli protoni o neutroni e i quark che formano un protone occupano lo stesso spazio dei quark che formano un protone adiacente. Questo meccanismo distorce i protoni o i neutroni che per brevi periodi possono avere dimensioni maggiori producendo l’effetto EMC.

La maggior parte dei fisici accetta questa interpretazione dell’effetto EMC, ma non tutti pensano che il gruppo di Hen abbia risolto il problema.

Ian Cloët, un fisico nucleare dell’Argonne National Laboratory in Illinois, ha dichiarato di ritenere che il lavoro di Hen trae conclusioni che i dati non supportano completamente ritenendo l’effetto EMC ancora irrisolto perché il modello di base della fisica nucleare rappresenta già molti degli accoppiamenti a corto raggio descritti da Hen e non risolve completamente il problema del nucleo atomico.

Ian Cloët ritiene che la spiegazione vada ricercata nella cromodinamica quantistica, o “QCD” che regola il comportamento dei quark.

Tutto risolto? Per nulla.

Le equazioni QCD che descrivono tutti i quark in un nucleo sono troppo difficili da risolvere, i supercomputer moderni sono ancora troppo lenti per farlo e forse serviranno altri 100 anni affinché diventino abbastanza veloci per risolverle. Se invece oggi fossero abbastanza potenti e veloci, non riuscirebbero comunque visto che le equazioni non sono sufficientemente avanzate. Ma la QCD potrebbe essere utilizzata per rispondere ad alcune domande e oggi quelle risposte potrebbero spiegare in modo diverso l’effetto EMC.

L’interno del nucleo atomico è la sede di forze molto intense, ha spiegato Cloët, simili a campi elettromagnetici che però interagiscono su distanze infinitamente piccole. Queste forze perdono tutta la loro intensità al di fuori del nucleo. Cloèt ha sviluppato un modello di questi campi di forza che ha chiamato “campi medi” che deformano la struttura interna di un protone o di un neutrone e dei pioni, particelle che trasportano una forza.

Per i ricercatori che hanno teorizzato i campi medi non ci sarebbe nessuna barriera nei nucleoni o meglio, questa barriera avrebbe dei buchi che consentirebbero alle forze di interagire con i quark deformando il nucleone stesso. La teoria del campo medio però è ancora da perfezionare e i risultati nei prossimi anni potrebbero rivelare molte sorprese.

In un esperimento in corso presso la Jefferson National Accelerator Facility in Virginia si tenta di spostare i nucleoni più vicini, un po’ alla volta, permettendo ai ricercatori di vederli cambiare. Ci si aspetta da un “esperimento EMC polarizzato” che spezzi l’effetto in base allo spin dei protoni coinvolti rivelando effetti che potrebbero chiarire cosa accade realmente.

Le ricerche sono ancora da affinare e i ricercatori dibattono ancora su molti temi, le due idee per ora rimangono in competizione.

Fonte: Live Science

La luna, Marte e oltre… La corsa allo spazio nel 2020

Quest’anno sono in programma una varietà sorprendente di ambiziose missioni spaziali. In effetti, gli ingegneri spaziali non hanno pianificavano così tanta attività in un solo anno – sia per i progetti con equipaggio che per i robot – sin dai tempi inebrianti della corsa allo spazio tra gli Stati Uniti e l’Unione Sovietica negli anni ’60. Alla fine, l’umanità sta tornando per esplorare i cieli con rinnovato vigore.

Tuttavia, non sono solo gli Stati Uniti e la Russia a dominare l’agenda spaziale di quest’anno.

India, Giappone e Cina stanno pianificando programmi complessi e stanno lottando per diventare potenze spaziali a pieno titolo. I loro piani per il 2020 includono missioni sulla luna, Marte e gli asteroidi.

Allo stesso tempo, gli Stati Uniti inaugureranno il programma Artemis, che alla fine porterà a una serie di missioni nello spazio profondo con equipaggio e una stazione spaziale che orbiterà attorno alla Luna intorno alla metà del decennio.

L’Europa sarà strettamente associata ad Artemis e invierà anche il suo primo robot rover su Marte nel 2020.

Per buona misura, gli Emirati Arabi Uniti prevedono di diventare una potenza spaziale nel 2020, con una propria missione robotica sul pianeta rosso.

La luna

La Cina punta a diventare la terza nazione a riportare sulla Terra campioni di terreno lunare sulla scia dei successi statunitensi e sovietici decenni fa. La sua missione robotica Chang’e 5 è programmata per patire dal centro di lancio spaziale Wenchang a Hainan alla fine del 2020. Lo scopo del progetto – intitolato alla dea cinese della luna, Chang’e – è quello di raccogliere circa 2 kg di rocce lunari e riportali sulla Terra. Un lander robot raccoglierà campioni in un veicolo che verrà lanciato nello spazio per attraccare automaticamente ad una sonda che circonda la Luna. I campioni verranno quindi trasferiti in una capsula e inviati sulla Terra.

Sarà un’attività molto complessa da svolgere in cui saranno necessari diversi attracchi e manovre in orbita.

La Missione Luna 24, realizzata nel 1976 dall’Unione Sovietica per riportare campioni lunari sulla Terra, fu realizzata in modo molto più semplice e un ritorno diretto della capsula contenente i campioni. La via più avventurosa scelta per Chang’e 5 è considerata da molti la prova che i cinesi stanno usando la missione come prova generale per gli sbarchi lunari con equipaggio nel prossimo futuro.

Gli scienziati statunitensi stanno pianificando una missione lunare alla fine del 2020, ma su una scala ancora più grande. La prima delle capsule Orion del paese è prevista per il lancio come parte di un volo di prova senza pilota del programma Artemis.

Orion trascorrerà circa tre settimane nello spazio, di cui sei giorni in orbita attorno alla luna. La capsula avrà un sistema di supporto vitale completo ma nessun equipaggio. Un modulo di servizio costruito in Europa svolgerà un ruolo chiave in tutte le missioni Artemis. Alimenterà le capsule di Orion dopo il loro lancio dal Kennedy Space Center della Nasa in Florida.

Le successive missioni della Orion, tuttavia, saranno presidiate, con l’obiettivo finale di far atterrare “la prima donna e il prossimo uomo” sulla luna entro il 2024. È anche prevista una stazione spaziale con equipaggio in orbita lunare, chiamata Lunar Gateway.

Inoltre, l’India invierà un nuovo lander sulla Luna a novembre: Chandrayaan-3. Tenterà di realizzare ciò che il suo predecessore non è riuscito a fare: l’atterraggio.

La missione Chandrayaan-2 è stato il primo tentativo dell’India di effettuare un atterraggio lunare, ma il suo lander, Vikram, contenente un rover si è schiantato a causa di un errore di comunicazione .

Marte

Il quarto pianeta del sistema solare sarà al centro dell’attenzione degli ingegneri spaziali quest’anno. A luglio e all’inizio di agosto, Terra e Marte saranno nella miglior posizione per il lancio di navi spaziali dirette verso quest’ultimo. La Nasa trarrà vantaggio da questa finestra di lancio con il suo rover Mars 2020, destinato a cercare prove che Marte fosse un luogo in cui l’acqua scorreva e la vita avrebbe potuto evolversi. Cercherà anche segni di antica vita microbica.

Mars 2020 segnerà anche l’inizio di un programma decennale di esplorazione marziana molto ambizioso. Il rover robot perforerà le rocce più promettenti, ne preleverà alcuni frammenti e li depositerà in tubi di metallo, li sigillerà e li lascerà in alcuni punti designati sulla superficie del pianeta.

Questi tubi saranno raccolti da future missioni congiunte europee e statunitensi e riportati sulla Terra – intorno al 2030. Circa 500 g di roccia verranno recuperati per essere esaminati nei laboratori di tutto il mondo, il che dovrebbe aumentare le nostre conoscenze sulle condizioni passate su Marte.

Il rover Mars 2020 sarà simile a Curiosity, il rover della NASA attualmente operativo su Marte, ma è stato aggiornato con telecamere di navigazione a colori ad alta risoluzione, un computer aggiuntivo per l’elaborazione di immagini e la creazione di mappe e software di navigazione automatica più sofisticato.

Anche l’Europa invierà un proprio rover robot su Marte quest’anno. Alla fine di luglio o all’inizio di agosto, un missile russo Proton lancerà un veicolo robot su Marte nell’ambito del progetto ExoMars dell’Agenzia spaziale europea.

Il rover è di costruzione britannica ed è stato nominato Rosalind Franklin, la donna che scoprì la doppia elica del DNA. Usando un trapano in grado di penetrare due metri sotto la superficie, il rover recupererà materiale che è stato schermato dall’intensa radiazione che bombarda Marte e che può contenere prove della vita passata e forse anche presente sul pianeta.

Tuttavia, il programma ExoMars ha già subito ritardi per problemi tecnici e i recenti fallimenti del suo sistema di atterraggio nelle prove hanno causato preoccupazioni reali per gli ingegneri che temono di dover ritardare ulteriormente la missione.

Che il lancio venga effettuato regolarmente dipenderà molto da come andranno i test di atterraggio che verranno eseguiti nei prossimi mesi. In caso di ulteriore rinvio, la prossima finestra di lancio si aprirà nel 2022.

Anche la Cina prevede inoltre di inviare una sonda su Marte nel 2020. Già in passato i cinesi avevano tentato di raggiungere il pianeta rosso, in collaborazione con la Russia. Tuttavia, l’astronave russa che trasportava la sonda cinese Yinghuo-1 si è schiantata nel gennaio 2012.

Successivamente, la Cina ha avviato il proprio programma di esplorazione su Marte e ha completato un cruciale test di sbarco nella provincia settentrionale di Hebei. Zhang Kejian, capo della China National Space Administration, ha affermato che il lander ha superato una serie di test in un sito studiato per simulare il terreno di Marte.

La sonda cinese, Huoxing-1, schiererà un orbiter e un rover che cadrà sulla superficie del pianeta. La missione sarà lanciata a luglio o agosto. Ancora una volta, l’obiettivo è quello di trovare prove della vita attuale e passata su Marte.

Per non essere da meno, gli Emirati Arabi Uniti hanno in programma di lanciare la loro prima sonda nello spazio profondo, la Hope Mars Mission, che è stata costruita al Mohammed bin Rashid Space Center in collaborazione con l’Università del Colorado e la Arizona State University. La navicella spaziale robot studierà il clima marziano e proverà a capire perché il pianeta abbia subito drastici cambiamenti climatici.

Asteroidi

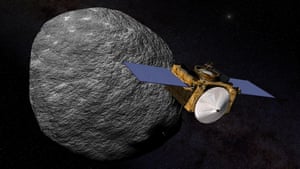

Osiris-Rex della Nasa, lanciato nel 2016, sta orbitando attorno a Bennu, un piccolo asteroide sferoidale con un diametro di circa 520 metri, fatto di roccia ricca di carbonio, un materiale che gli scienziati ritengono rappresentativo della nuvola di gas e polvere turbinanti da cui il sistema solare si è formato 4,6 miliardi di anni fa.

Quest’estate, Osiris-Rex si sposterà vicino alla superficie di Bennu, estenderà un braccio robotico e rilascerà un getto di gas che farà sollevare dalla superficie alcuni frammenti di roccia e polvere che saranno aspirati da un apposito tubo di raccolta. Il veicolo spaziale inizierà quindi il suo viaggio verso casa, rilasciando un contenitore con campioni dell’asteroide all’interno che arriverà sulla Terra nel settembre 2023, scendendo nel deserto dello Utah.

È probabile che Osiris-Rex venga anticipato dalla missione giapponese Hayabusa2. Ha incontrato l’asteroide 162173 Ryugu nel giugno 2018 e lo ha studiato per un anno e mezzo prima di prelevare campioni che ora sta riportando sulla Terra. La sonda e il suo carico dovrebbero raggiungere la Terra alla fine del 2020.

Lanci commerciali

SpaceX non è l’unica compagnia privata a costruire astronavi per il programma commerciale con equipaggio della Nasa.

Anche Boeing ha anche in programma di far volare gli astronauti verso la stazione spaziale con la sua astronave Starliner. Tuttavia, non è chiaro quando ciò accadrà. A dicembre, una versione senza equipaggio è stata lanciata in orbita con l’obiettivo di raggiungere la stazione spaziale. Tuttavia, la capsula non è riuscita a raggiungere la sua quota corretta a causa di un malfunzionamento del computer e l’imbarcazione è dovuta rientrare a Terra.

Boeing sta ora rivedendo i dati di telemetria inviati da Starliner per determinare se il suo prossimo lancio deve essere presidiato o se deve ripetere un altro volo senza pilota. Quando sarà pienamente operativa, la capsula sarà in grado di trasportare fino a sette astronauti, la stessa capacità della Crew Dragon.

Una questione di pressione

Noi viviamo sul fondo di un enorme oceano d’aria che ogni giorno esercita su di noi una terribile pressione. Eppure diamo per scontato densità e pressione atmosferica sottovalutando l’impatto della sua pervasiva presenza.

Immaginiamo un tubicino di base pari ad un centimetro quadrato che si innalza lunghissimo nel cielo fino a toccare la fine della nostra atmosfera, ovvero 150 km. Ebbene l’aria intrappolata dentro questo tubicino (soltanto l’aria non l’immaginario tubo) pesa su quel singolo centimetro quadrato di superficie terrestre un chilogrammo.Questo è uno dei sistemi di misurazione della pressione, 1,03 chili per centimetro quadrato rappresenta l’unità di misura standard della pressione.

Un altro modo per misurare la pressione atmosferica (e qualunque altro tipo di pressione) è attraverso questa semplicissima equazione P=f/a ovvero forza fratto aerea. Per capire bene l’importanza della relazione tra la forza e l’area su cui si esercita e quindi sul livello di pressione relativo, affidiamoci ad un piccolo esempio.

Immaginiamo di essere usciti in una fredda giornata di fine inverno insieme alla bella Jessica per pattinare sulla superficie di un lago ghiacciato. Sfortunatamente Jessica, che state cercando da mesi (e senza successo) di conquistare, attraversa una lastra particolarmente sottile di ghiaccio che si rompe e la inghiotte.

L’imperativo è salvarla senza affogare anche noi miseramente. Quindi ci sdraiamo sulla pancia ed avanziamo lentamente verso la buca dove la bella Jessica annaspa spaventata. La differenza di pressione sul ghiaccio tra noi in piedi e noi sdraiati è notevolissima. Vediamo un po’ di calcolarne il differenziale, se pesiamo 70 kg. Se stiamo in piedi la superficie di entrambi i nostri piedi è all’incirca 500 cm quadrati ed esercita una pressione di circa 700 chili per mezzo metro quadrato. Strisciando sdraiati e supponendo di essere alti 180 cm invece distribuiamo la pressione su circa 8000 cm quadrati, sedici volte di meno della stazione eretta. Quindi maggiore è l’area minore è la pressione, maggiore le probabilità di raggiungere la buca e salvare la ragazza che ci sta tanto a cuore senza imitarne la fine.

E per continuare con questi giochetti mentali immaginiamo la nostra mano, tesa perpendicolarmente con il palmo in su. Approssimativamente l’area della nostra mano è di circa 150 cm quadrati, riceviamo quindi una pressione verso il basso di 150 chilogrammi!

Come facciamo a mantenere il nostro braccio perpendicolare nonostante questa forza? Molto semplicemente la pressione agisce anche sotto il nostro braccio e in questo caso riceviamo una pressione verso l’alto di 150 chili.

Perché la nostra povera mano non viene stritolata da tutta questa pressione? semplicemente perché le nostre ossa sono sufficientemente forti da reggerla.

Lo stesso principio vale per la pressione che si esercita sulla nostra cassa toracica: quello che impedisce che essa collassi schiacciando i nostri polmoni è la presenza di una pressione identica dentro di noi che equilibra quella esterna. Le case non collassano sotto la pressione dell’atmosfera perché la pressione dell’aria al loro interno è la stessa di quella all’esterno, questo stato si chiama equilibrio di pressione.

Il fatto di non avvertire quasi mai gli effetti della pressione non riduce l’importante ruolo che essa gioca nella vita di tutti i giorni, ad iniziare dalle condizioni meteo.

Tutti sappiamo che l’alta pressione è sinonimo di bel tempo mentre la bassa pressione in genere annuncia eventi perturbativi. Lo strumento che misura la pressione è il barometro, il cui primo esemplare ad acqua, pare fu progettato ufficialmente nel 1641 da Giovanni Battista Baliani; tuttavia sembrerebbe che tale strumento, sebbene in versioni più rudimentali, fosse già in utilizzo dai Padri Pellegrini durante le navigazioni verso il Nuovo Mondo.

Ma ora scusatemi, la bella Jessica grata per averla salvata da una fine orribile mi sta mostrando tutta la sua gratitudine…