- Un decodificatore semantico che trasforma l'attività cerebrale in testo è stato sviluppato dai ricercatori dell'Università del Texas ad Austin. Questo sistema di intelligenza artificiale, che non è invasivo e non richiede impianti chirurgici, potrebbe fornire un nuovo mezzo di comunicazione per le persone che non sono in grado di parlare fisicamente, come chi ha subito un ictus.

- Domande frequenti

Un decodificatore semantico che trasforma l’attività cerebrale in testo è stato sviluppato dai ricercatori dell’Università del Texas ad Austin. Questo sistema di intelligenza artificiale, che non è invasivo e non richiede impianti chirurgici, potrebbe fornire un nuovo mezzo di comunicazione per le persone che non sono in grado di parlare fisicamente, come chi ha subito un ictus.

Un nuovo sistema di intelligenza artificiale chiamato decodificatore semantico può tradurre l’attività cerebrale di una persona – mentre ascolta una storia o immagina silenziosamente di raccontare una storia – in un flusso continuo di testo. Il sistema sviluppato dai ricercatori dell’Università del Texas ad Austin potrebbe aiutare le persone che sono mentalmente coscienti ma incapaci di parlare fisicamente, come chi ha subito danni da un ictus, a comunicare di nuovo in modo intelligibile.

Lo studio, pubblicato il 1 maggio sulla rivista Nature Neuroscience, è stato condotto da Jerry Tang, studente di dottorato in informatica, e Alex Huth, assistente professore di neuroscienze e informatica presso l’UT Austin. Il lavoro si basa in parte su un modello di trasformatore, simile a quelli che alimentano ChatGPT di Open AI e Bard di Google.

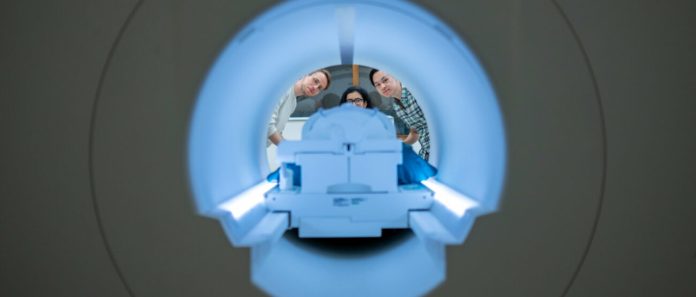

A differenza di altri sistemi di decodifica linguistica in fase di sviluppo, questo sistema non richiede ai soggetti di avere impianti chirurgici, rendendo il processo non invasivo. Inoltre, i partecipanti non devono utilizzare solo le parole previste in un elenco prestabilito. L’attività cerebrale viene misurata utilizzando uno scanner fMRI dopo un lungo addestramento del decodificatore, in cui l’individuo ascolta ore di podcast nello scanner. Successivamente, a condizione che il partecipante sia disposto a far decodificare i propri pensieri, l’ascolto di una nuova storia o l’immaginazione di raccontare una storia consente alla macchina di generare il testo corrispondente dalla sola attività cerebrale.

“Per un metodo non invasivo, questo è un vero balzo in avanti rispetto a ciò che è stato fatto prima, che in genere è composto da singole parole o brevi frasi“, ha detto Huth. “Stiamo facendo in modo che il modello decodifichi il linguaggio continuo per lunghi periodi di tempo con idee complesse“.

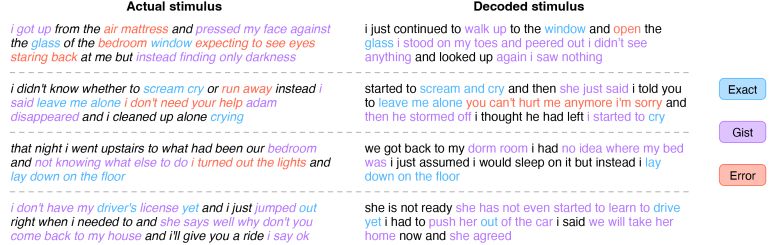

Il risultato non è una trascrizione parola per parola. Invece, i ricercatori lo hanno progettato per catturare l’essenza di ciò che viene detto o pensato, anche se in modo imperfetto. Circa la metà delle volte, quando il decodificatore è stato addestrato a monitorare l’attività cerebrale di un partecipante, la macchina produce un testo che corrisponde strettamente (e talvolta con precisione) ai significati previsti delle parole originali.

Annuncio pubblicitario

Interessato all'Intelligenza Artificiale?

Prova a leggere su Amazon Unlimited la nostra guida su come installarne una in locale e come ricavarne il massimo.

Una Intelligenza Artificiale locale ti permette di usufruire di tutti i vantaggi derivanti dall'uso dell'IA ma senza dover pagare costosi abbonamenti.

📘 Leggi la guida su AmazonAd esempio, negli esperimenti, un partecipante che ascoltava un oratore dire “Non ho ancora la patente di guida” ha tradotto i suoi pensieri come “Non ha ancora iniziato a imparare a guidare“. Ascoltando le parole: “Non sapevo se urlare, piangere o scappare. Invece, ho detto, ‘Lasciami in pace!’” è stato decodificato come, “Ha iniziato a urlare e piangere, e poi ha semplicemente detto, ‘Ti avevo detto di lasciarmi in pace‘”.

A partire da una versione precedente del documento che è apparso come prestampa online, i ricercatori hanno affrontato domande sul potenziale uso improprio della tecnologia. Il documento descrive come la decodifica funzionava solo con partecipanti cooperativi che avevano partecipato volontariamente all’addestramento del decodificatore. I risultati per gli individui sui quali il decodificatore non era stato addestrato erano incomprensibili e se i partecipanti sui quali il decodificatore era stato addestrato in seguito opponevano resistenza, ad esempio pensando altri pensieri, i risultati erano ugualmente inutilizzabili.

“Prendiamo molto sul serio le preoccupazioni che possa essere utilizzato per scopi negativi e abbiamo lavorato per evitarlo“, ha affermato Tang. “Vogliamo assicurarci che le persone utilizzino questi tipi di tecnologie solo quando lo desiderano e che ciò li aiuti“.

Oltre a far o pensare o ascoltare ai partecipanti delle storie, i ricercatori hanno chiesto ai soggetti di guardare quattro brevi video silenziosi mentre si trovavano nello scanner. Il decodificatore semantico è stato in grado di utilizzare la loro attività cerebrale per descrivere accuratamente determinati eventi dai video.

Il sistema attualmente non è pratico per l’uso al di fuori del laboratorio a causa della sua dipendenza dal tempo necessario su una macchina fMRI. Ma i ricercatori pensano che questo lavoro potrebbe essere trasferito ad altri sistemi di imaging cerebrale più portatili, come la spettroscopia funzionale nel vicino infrarosso (fNIRS).

“La fNIRS misura dove c’è più o meno flusso sanguigno nel cervello in diversi momenti nel tempo, il che, a quanto pare, è esattamente lo stesso tipo di segnale misurato dalla fMRI“, ha detto Huth. “Quindi, il nostro esatto tipo di approccio dovrebbe tradursi in fNIRS“, anche se, ha osservato, la risoluzione con fNIRS sarebbe inferiore.

Questo lavoro è stato sostenuto dalla Whitehall Foundation, dalla Alfred P. Sloan Foundation e dal Burroughs Wellcome Fund.

Gli altri coautori dello studio sono Amanda LeBel, ex assistente di ricerca nel laboratorio Huth, e Shailee Jain, una studentessa laureata in informatica all’UT Austin.

Alexander Huth e Jerry Tang hanno depositato una domanda di brevetto PCT relativa a questo lavoro.

Domande frequenti

Questa tecnologia potrebbe essere utilizzata su qualcuno senza che lo sappia, ad esempio da un regime autoritario che interroga i prigionieri politici o da un datore di lavoro che spia i dipendenti?

No. Il sistema deve essere ampiamente addestrato su un soggetto disponibile in una struttura con attrezzature grandi e costose. “Una persona ha bisogno di trascorrere fino a 15 ore sdraiata in uno scanner MRI, essere perfettamente immobile e prestare molta attenzione alle storie che sta ascoltando prima che questo funzioni davvero bene su di loro”, ha detto Huth.

La formazione potrebbe essere saltata del tutto?

No. I ricercatori hanno testato il sistema su persone su cui non era stato addestrato e hanno scoperto che i risultati erano incomprensibili.

Ci sono modi in cui qualcuno può difendersi dalla decodifica dei propri pensieri?

SÌ. I ricercatori hanno testato se una persona che aveva precedentemente partecipato alla formazione potesse resistere attivamente ai successivi tentativi di decodifica del cervello. Tattiche come pensare agli animali o immaginare tranquillamente di raccontare la propria storia consentono ai partecipanti di impedire facilmente e completamente al sistema di recuperare il discorso a cui la persona è stata esposta.

E se la tecnologia e la ricerca correlata si evolvessero per superare un giorno questi ostacoli o difese?

“Penso che in questo momento, mentre la tecnologia è in uno stato così precoce, sia importante essere proattivi attuando politiche che proteggano le persone e la loro privacy“, ha detto Tang. “Anche pensare per tempo a regole per l’utilizzo di questi dispositivi sarebbe molto importante.”

Riferimento: “Semantic reconstruction of continuous language from non-invasive brain recordings” 1 maggio 2023, Nature Neuroscience .

DOI: 10.1038/s41593-023-01304-9