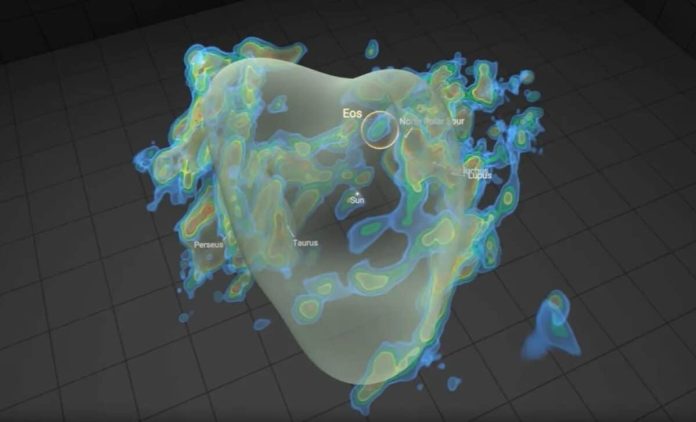

Una scoperta astronomica di portata eccezionale ha recentemente catturato l’attenzione della comunità scientifica: l’identificazione di una colossale nube molecolare situata a una distanza sorprendentemente ravvicinata di soli 300 anni luce dal nostro Sistema Solare. Questa imponente struttura cosmica, battezzata Eos, si annovera tra le più vaste entità celesti osservabili e possiede un potenziale inestimabile per svelare nuovi dettagli fondamentali sui processi di formazione stellare e planetaria.

Svelato Eos: un gigante gassoso

Se potessimo osservarla direttamente nel cielo notturno, Eos si estenderebbe per una regione apparente pari a circa 40 volte la dimensione della Luna piena, testimoniando la sua grandezza intrinseca. La sua composizione è dominata dall’idrogeno molecolare, elemento primordiale e costituente essenziale per l’innesco della nucleosintesi stellare e per l’aggregazione di materia che conduce alla nascita di nuovi sistemi planetari. La prossimità al nostro sistema solare offre agli scienziati un’opportunità senza precedenti per investigare da vicino le fasi embrionali della formazione stellare con un livello di dettaglio altrimenti irraggiungibile.

Questa scoperta segna un avanzamento significativo nella comprensione delle nubi molecolari e del loro ruolo dinamico nel processo cosmico di creazione di nuove stelle. L’entusiasmo della comunità scientifica è particolarmente elevato in virtù della sua posizione privilegiata: essa rappresenta una delle regioni di formazione stellare più vicine al nostro sistema solare, fornendo una finestra osservativa unica sui meccanismi che governano la nascita di stelle e sistemi planetari proprio nel nostro “vicinato” galattico.

Eos ha rapidamente catalizzato l’interesse degli scienziati per una molteplicità di ragioni. Non solo si distingue come una delle nubi molecolari più estese mai individuate, ma la sua collocazione insolitamente vicina al Sistema Solare la eleva a oggetto di studio di straordinario valore scientifico. La nube si dispiega su una regione spaziale immensa, estendendosi per un’area circa quaranta volte superiore a quella occupata dalla Luna piena nel nostro cielo, e si trova immersa all’interno del mezzo interstellare, la vasta distesa tra i sistemi stellari permeata da gas rarefatto e polveri cosmiche.

Implicazioni per la comprensione della formazione stellare e planetaria

Secondo le analisi dei ricercatori, la nube Eos si presenta con una distintiva morfologia a forma di croissant ed è composta prevalentemente da idrogeno molecolare, l’elemento fondamentale che costituisce la materia prima per la formazione di stelle e pianeti. La scoperta di questa nube riveste un significato particolare in quanto l’idrogeno molecolare, pur essendo l’elemento più abbondante nell’Universo, risulta notoriamente difficile da rilevare direttamente.

Tradizionalmente, nubi di questo tipo venivano studiate principalmente attraverso osservazioni indirette, analizzando le emissioni di onde radio o infrarosse associate a tracce di altre molecole o alla polvere interstellare. La peculiarità della nuova scoperta risiede nel fatto che è stata identificata grazie alla sua emissione nello spettro dell’ultravioletto lontano, aprendo nuove finestre osservative.

Le dimensioni considerevoli e la composizione chimica di Eos offrono agli astronomi un’opportunità unica per approfondire la comprensione delle condizioni ambientali specifiche che sono necessarie per l’innesco della formazione di nuove stelle e sistemi planetari. Lo studio dettagliato di questa nube potrebbe fornire risposte cruciali a interrogativi fondamentali riguardanti le fasi iniziali dell’evoluzione stellare, gettando luce sui meccanismi che governano il collasso gravitazionale del gas, la frammentazione e l’accensione delle protostelle.

Nonostante la sua relativa vicinanza al Sistema Solare, si distingue anche per le sue grandi dimensioni e per la sua elevata attività interna, probabilmente legata a processi di turbolenza e di collasso gravitazionale in corso. Questa combinazione di prossimità e dinamicità la rende un laboratorio cosmico ineguagliabile per studiare i meccanismi di formazione stellare con un livello di dettaglio e precisione altrimenti irraggiungibile. La vicinanza della nube permette agli scienziati di osservare l’idrogeno molecolare con una risoluzione spaziale elevata, con la concreta possibilità di svelare i segreti della nascita delle stelle e dell’aggregazione della materia circostante per formare i pianeti.

L’importanza di questa scoperta, che apre inedite possibilità per l’indagine delle nubi molecolari, è stata sottolineata da Blakesley Burkhart, professore associato alla Rutgers University, che ha efficacemente descritto Eos come una nube che “brilla letteralmente al buio“, riferendosi alla modalità di rilevamento unica nello spettro ultravioletto lontano. Questa nuova metodologia per studiare direttamente le molecole di idrogeno potrebbe potenzialmente rivoluzionare la nostra attuale comprensione della fisica e della chimica delle nubi molecolari e del loro ruolo centrale nel ciclo di vita cosmico della materia.

Questa scoperta non si limita a illuminare i processi molecolari attuali, ma stabilisce anche un affascinante collegamento tra il presente e il remoto passato cosmico. Le molecole di idrogeno che costituiscono la nube risalgono addirittura all’epoca del Big Bang, e hanno intrapreso un lento e millenario viaggio attraverso l’universo fino a concentrarsi nella nostra regione galattica. È suggestivo pensare che gli stessi atomi di idrogeno presenti potrebbero aver avuto origine circa 13,6 miliardi di anni fa e aver vagato nello spazio per poi confluire nella nostra porzione della Via Lattea.

La presenza di queste molecole primordiali fornisce un legame tangibile tra l’Universo nelle sue fasi iniziali e lo stato attuale delle nubi molecolari all’interno della nostra galassia, suggerendo che gli elementi costitutivi fondamentali della vita e delle stelle sono in continuo movimento da miliardi di anni, spostandosi lentamente verso i luoghi dove vengono ciclicamente utilizzati per dare origine a nuove generazioni di stelle e sistemi planetari.

Un faro per l’esplorazione intergalattica e la comprensione cosmica

Al di là del suo impatto diretto sullo studio dei meccanismi di formazione stellare all’interno della nostra galassia, la scoperta della nube molecolare Eos possiede implicazioni di vasta portata per l’intera ricerca astronomica e per l’approfondimento della nostra comprensione dell’ambiente cosmico nella sua globalità. L’analisi dettagliata della composizione chimica e del comportamento fisico di Eos potrebbe fornire preziose informazioni ai ricercatori riguardo alle caratteristiche delle nubi di gas presenti in galassie esterne alla Via Lattea, aprendo potenzialmente nuove prospettive sulle complesse dinamiche delle interazioni intergalattiche e sull’evoluzione su larga scala delle strutture cosmiche.

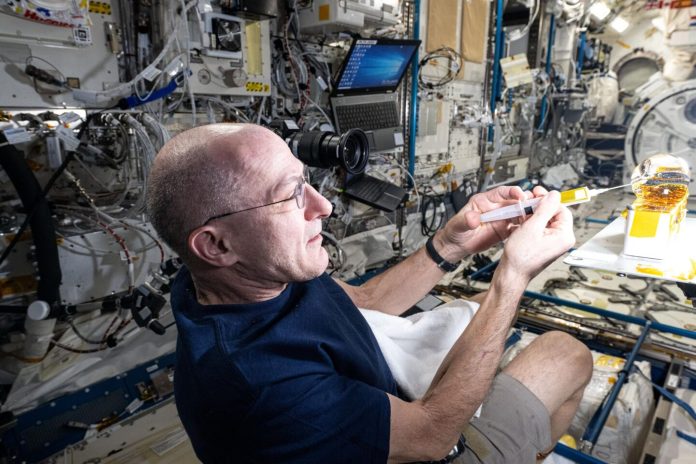

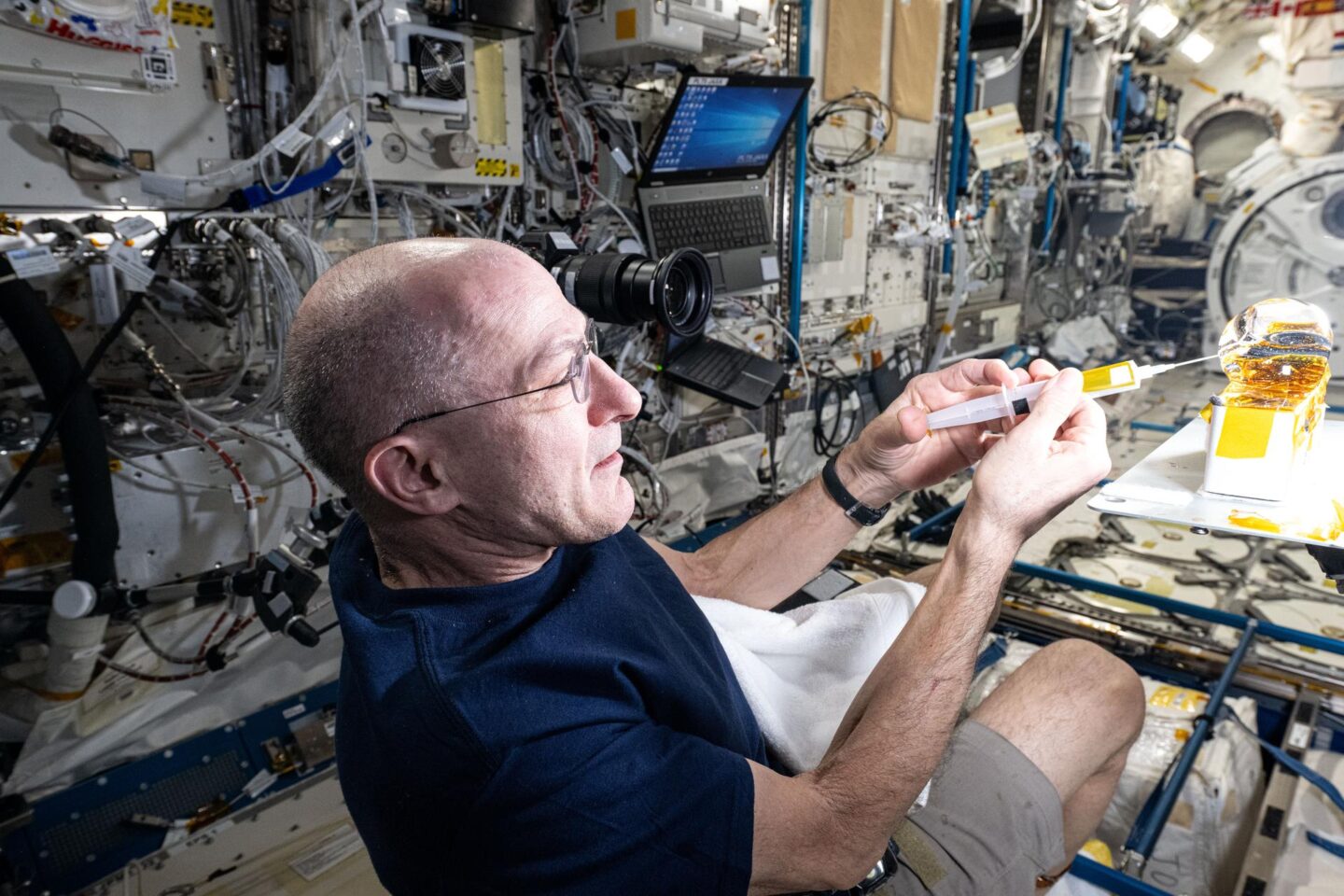

Parallelamente alla sua scoperta nel nostro “vicinato” galattico, il potente telescopio spaziale James Webb (JWST) sta giocando un ruolo cruciale nell’estendere i nostri orizzonti osservativi verso regioni cosmiche remote. Grazie alle sue capacità uniche nello spettro infrarosso, il JWST è stato impiegato con successo per osservare l’idrogeno molecolare in galassie situate ben oltre i confini della Via Lattea, spingendo ulteriormente la nostra esplorazione verso l’ignoto cosmico e fornendo dati fondamentali sulle condizioni fisiche e chimiche in ambienti galattici distanti.

Questa visione in continua espansione della distribuzione e delle proprietà dell’idrogeno molecolare, sia nelle nostre immediate vicinanze cosmiche che nelle profondità dello spazio intergalattico, si rivela fondamentale per decifrare la struttura fondamentale del nostro Universo. Dalla sua abbondanza primordiale nei primi istanti successivi al Big Bang alla sua aggregazione nelle vaste nubi molecolari che danno origine a nuove stelle e galassie, l’idrogeno molecolare rappresenta un elemento costitutivo essenziale per comprendere l’evoluzione cosmica nella sua interezza, dalla sua genesi alla sua attuale configurazione.

La ricerca è stata pubblicata su Nature.