Le IA in grado di generare video, tradurre rapidamente lingue o scrivere nuovi codici informatici potrebbero davvero cambiare il mondo ma potranno mai essere veramente intelligenti?

Non secondo quella che viene chiamata l’ipotesi dell’incarnazione, una teoria che sostiene che l’intelligenza a livello umano può emergere solo se vive immersa in un ambiente fisico, percependo tutte le sensazioni, e quindi gli input, animato invia al cervello.

Secondo questa teoria, l’unico modo per far sì che un’intelligenza artificiale sviluppi una vera intelligenza è darle un corpo e la capacità di muoversi e sperimentare il mondo. Le IA solo digitali, sempre secondo questa idea, possono essere ottime per compiti limitati, ma saranno sempre limitate dalla mancanza di esperienze dirette.

“I sistemi di intelligenza artificiale privi di un’incarnazione fisica non potranno mai essere veramente intelligenti”, ha affermato Akshara Rai, ricercatore presso Meta. “Per comprendere appieno il mondo, è essenziale interagire con esso e osservare i risultati di tali interazioni”.

Non tutti gli sviluppatori di intelligenza artificiale credono nella necessità dell’incarnazione: potrebbe essere possibile creare una superintelligenza esclusivamente digitale che non senta mai la Terra sotto i suoi piedi robotici.

Molti di coloro che lo pensano, tuttavia, sono concentrati sulla ricerca del modo più sicuro ed efficiente per consentire alle IA di esplorare il mondo fisico.

Il mondo (non così) reale

I bambini commettono molti errori quando imparano per la prima volta a fare qualcosa ed è probabile che anche l’intelligenza artificiale farà molti errori durante l’addestramento. Il problema è che se l’IA stesse controllando una macchina nel momento in cui commette questi errori, potrebbe distruggere l’hardware, danneggiare il mondo circostante e forse anche ferire le persone.

Annuncio pubblicitario

Interessato all'Intelligenza Artificiale?

Prova a leggere su Amazon Unlimited la nostra guida su come installarne una in locale e come ricavarne il massimo.

Una Intelligenza Artificiale locale ti permette di usufruire di tutti i vantaggi derivanti dall'uso dell'IA ma senza dover pagare costosi abbonamenti.

📘 Leggi la guida su AmazonUn’intelligenza artificiale potrebbe anche dover tentare qualcosa molte volte prima di capire come farlo in modo affidabile. Moltiplicandolo per tutti i compiti leggermente diversi che potremmo volere che un robot AI sia in grado di svolgere, il periodo di addestramento potrebbe diventare interminabile.

Le simulazioni al computer che imitano gli ambienti che un’intelligenza artificiale incarnata probabilmente incontrerà nel mondo reale sono un modo per aggirare entrambi i problemi.

A un’intelligenza artificiale in fase di sviluppo può essere dato il controllo di un corpo virtuale e quindi potrà addestrarsi in un programma di simulazione. Ciò offrirebbe all’intelligenza artificiale un modo rapido e a basso rischio per apprendere cosa probabilmente accadrà quando avrà il controllo di un vero robot.

Poiché le simulazioni non devono muoversi alla velocità del mondo reale, un’intelligenza artificiale può imparare molto più rapidamente: quando il MIT ha addestrato un robot ghepardo alimentato dall’intelligenza artificiale, ad esempio, le simulazioni hanno consentito all’intelligenza artificiale di sperimentare 100 giorni di corsa in sole tre ore.

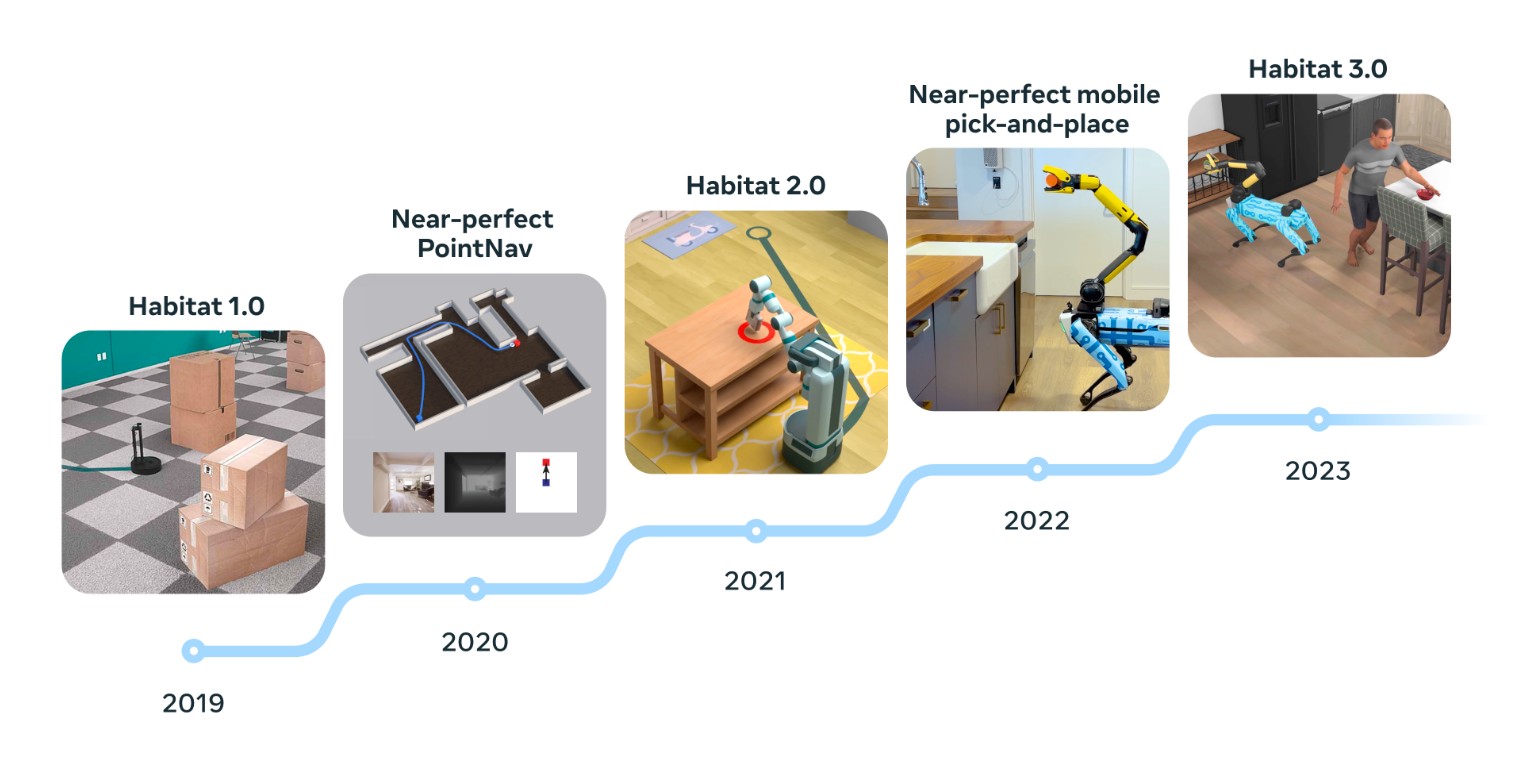

Nel 2019, Meta (allora Facebook) ha presentato AI Habitat, una piattaforma di simulazione open source per addestrare le IA a spostarsi in case, uffici e altri spazi.

AI Habitat addestra le IA ad aprire porte, recuperare oggetti e molto altro in una varietà di ambienti. Si spera che le IA così addestrate saranno abbastanza intelligenti da riuscire a fare le stesse cose in ambienti in cui non sono mai state, il che sarà fondamentale per l’implementazione dei robot nelle case e nei luoghi di lavoro.

Nell’ottobre 2023, Meta ha aggiornato la piattaforma e questa versione ha introdotto avatar umani nel mondo simulato.

“La prima iterazione nel 2019 ha addestrato i robot virtuali a navigare rapidamente nelle scansioni 3D delle case del mondo reale, e Habitat 2.0 ha introdotto ambienti interattivi in modo che i robot virtuali potessero raccogliere oggetti o aprire cassetti”, spiega Roozbeh Mottaghi, manager ricercatore sull’intelligenza artificiale di Meta.

“Habitat 3.0 consente la collaborazione virtuale tra robot e persone, in cui i robot si adattano ad ambienti non stazionari e tengono conto delle azioni, dei movimenti e delle intenzioni degli esseri umani”.

Limitazioni

Il nuovo AI Habitat è fondamentale per lo sviluppo dell’intelligenza artificiale tradizionale – affinché i robot siano integrati con successo nelle nostre vite, devono capire come interagire con noi – ma quanto un’intelligenza artificiale possa imparare sulla coesistenza con le persone dalle simulazioni è da vedere.

“Gli esseri umani hanno prospettive diverse tra loro, obiettivi diversi, capacità diverse… Come esseri umani, non possiamo nemmeno scrivere le regole delle norme sociali in un mondo così complesso”, commenta Boyuan Chen, capo del General Robotics Lab della Duke University.

Gli esseri umani non sono nemmeno l’unica variabile ultra complessa nelle simulazioni.

Anche la fisica del mondo reale è incredibilmente difficile da simulare, il che può portare a quello che gli sviluppatori di robot chiamano il “divario tra simulazione e realtà” – un fenomeno in cui un’intelligenza artificiale funziona meglio nelle simulazioni rispetto a quando gli viene dato il controllo di un corpo fisico.

“Anche cose semplici, come una palla che rimbalza… non possono essere modellate molto bene in una simulazione, per non parlare della fluidodinamica molto complessa e della combustione molto complessa“, ha affermato Chen.

Migliorare continuamente le nostre simulazioni può aiutare a colmare il divario tra simulazione e realtà, ma alla fine arriva un punto in cui l’unica opzione è dare a un’intelligenza artificiale il suo corpo e uno spazio sicuro per fallire.

L’intelligenza artificiale incorporata è ora al punto che alcune aziende sono pronte a fare il passo successivo e inviare effettivamente i loro robot basati sull’intelligenza artificiale nel mondo reale, come i genitori accompagnano i propri figli a scuola per la prima volta.

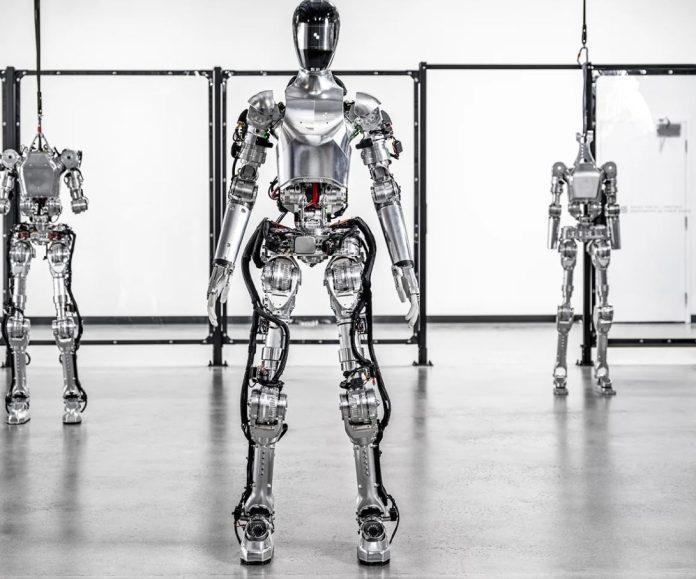

La startup di robotica Agility Robotics ha distribuito i suoi robot Digit in una struttura di ricerca e sviluppo di Amazon, mentre Apptronik, che sviluppa robot umanoidi, sta inviando i suoi robot Apollo a lavorare in una fabbrica Mercedes-Benz per verificare che possano operare in modo sicuro ed efficace accanto alle persone.

Nel frattempo, Figure, startup di robotica sostenuta da OpenAI, sta implementando i suoi umanoidi IA in uno stabilimento di produzione BMW.

L’intelligenza artificiale di OpenAI e i robot Figure

Figure ha recentemente dimostrato un aggiornamento del cervello del suo robot con un modello di linguaggio visivo (VLM), addestrato da OpenAI, il che significa che ora può comprendere il parlato, eseguire comandi verbali e persino spiegare perché sta facendo quello che sta facendo.

Il robot potrebbe essere ancora molto meno intelligente di un essere umano, ma OpenAI e Figure lavoravano insieme solo da 13 giorni quando hanno pubblicato il video, ed è stato un enorme passo avanti rispetto all’ultima demo di Figure, rilasciata a febbraio, in cui il robot semplicemente spostava una borsa da un posto all’altro.

Se l’ipotesi dell’incarnazione è vera, l’abbinamento di un’azienda che sviluppa alcuni dei cervelli IA più avanzati con un’azienda che costruisce corpi robotici all’avanguardia potrebbe essere la combinazione che porterà a una vera intelligenza simile a quella umana in un essere artificiale – e presto.