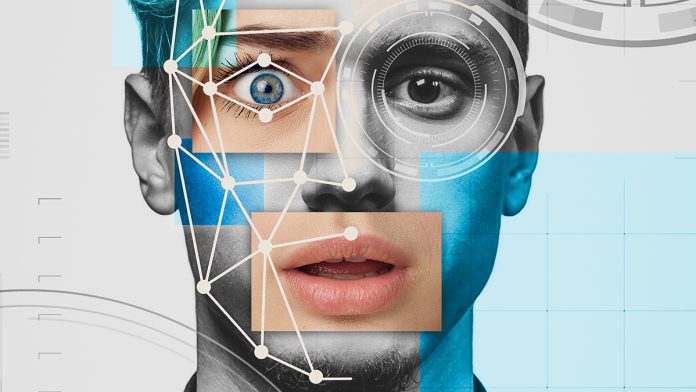

La maggior parte dei deepfake (video con false riproduzioni iperrealistiche) generati dall’intelligenza artificiale (AI) che si diffondono attraverso i social media presentano rappresentanti politici e artisti e sono spesso collegati ai cicli di notizie attuali.

I deepfake virali generati dall’AI riguardano politici e artisti

Una ricerca dell’Universidad Carlos III de Madrid (UC3M) ha analizzato le caratteristiche formali e di contenuto della disinformazione virale in Spagna derivante dall’uso di strumenti di intelligenza artificiale per scopi illeciti. Questo progresso rappresenta un passo avanti verso la comprensione e la mitigazione delle minacce generate dalle bufale nella nostra società.

Nello studio il gruppo di ricerca ha studiato i deepfake attraverso le verifiche delle organizzazioni spagnole di controllo dei fatti, come EFE Verifica, Maldita, Newtral e Verifica RTVE.

“L’obiettivo era identificare una serie di modelli e caratteristiche comuni a questi deepfake virali, fornire alcuni indizi per la loro identificazione e avanzare alcune proposte di alfabetizzazione mediatica in modo che i cittadini possano contrastare la disinformazione“, ha spiegato una delle autrici, Raquel Ruiz Incertis ricercatrice presso il Dipartimento di Comunicazione dell’UC3M.

Annuncio pubblicitario

Interessato all'Intelligenza Artificiale?

Prova a leggere su Amazon Unlimited la nostra guida su come installarne una in locale e come ricavarne il massimo.

Una Intelligenza Artificiale locale ti permette di usufruire di tutti i vantaggi derivanti dall'uso dell'IA ma senza dover pagare costosi abbonamenti.

📘 Leggi la guida su AmazonLo studio

I ricercatori hanno sviluppato una tipologia di deepfake che ne facilita l’identificazione e la neutralizzazione. Secondo i risultati dello studio, alcuni leader politici (come Trump o Macron) sono stati i principali protagonisti di contenuti che facevano riferimento all’uso di droghe o ad attività moralmente riprovevoli.

Esiste anche una percentuale considerevole di deepfake pornografici che hanno danneggiato l’integrità delle donne, in particolare esponendo cantanti e attrici famose. Generalmente vengono condivisi da account non ufficiali e si diffondono rapidamente tramite servizi di messaggistica istantanea.

La proliferazione dei deepfake, ovvero l’uso frequente di immagini, video o audio manipolati con strumenti di intelligenza artificiale, è un tema di grande attualità: “Questo tipo di bufale prefabbricate è particolarmente dannoso in situazioni delicate, come nei periodi pre-elettorali o in tempi di conflitto come quelli che stiamo vivendo attualmente in Ucraina o a Gaza. Questo è quelo che chiamiamo ‘guerre ibride’: la guerra è non si combatte solo nel regno fisico, ma anche in quello digitale, e le falsità sono più significative che mai“, ha spiegato Ruiz Incertis.

Le applicazioni di questa ricerca sono diverse, dalla sicurezza nazionale all’integrità delle campagne elettorali. I risultati hanno indicato che l’uso proattivo dell’intelligenza artificiale sulle piattaforme di social media potrebbe rivoluzionare il modo in cui manteniamo l’autenticità delle informazioni nell’era digitale.

Conclusioni

La ricerca ha evidenziato la necessità di una maggiore alfabetizzazione mediatica e propone strategie educative per migliorare la capacità del pubblico di discernere tra contenuti reali e manipolati.

“Molti di questi deepfake possono essere identificati attraverso la ricerca inversa di immagini su motori di ricerca come Google o Bing. Esistono strumenti che consentono al pubblico di verificare l’accuratezza dei contenuti in un paio di clic prima di diffondere contenuti di dubbia origine. La chiave è insegnare spiegargli come farlo“, ha osservato Ruiz Incertis.

Fornisce inoltre altri suggerimenti per individuare i deepfake, come prestare attenzione alla nitidezza dei bordi degli elementi e alla definizione dello sfondo dell’immagine: se i movimenti sono rallentati nei video o se c’è qualche alterazione del viso, sproporzione corporea o strano gioco di luci e ombre, tutto indica che potrebbe trattarsi di contenuto generato dall’intelligenza artificiale.

Inoltre, gli autori dello studio vedono anche la necessità di una legislazione che obblighi le piattaforme, le applicazioni e i programmi (come Midjourney o Dall-e) a stabilire una “filigrana” che li identifichi e permetta all’utente di sapere a colpo d’occhio che l’immagine o il video è stato modificato o creato interamente con l’intelligenza artificiale.

Il gruppo di ricerca ha utilizzato un approccio multidisciplinare, combinando scienza dei dati e analisi qualitativa, per esaminare come le organizzazioni di controllo dei fatti applicano l’intelligenza artificiale nelle loro operazioni. La metodologia principale è un’analisi del contenuto di una trentina di pubblicazioni tratte dai siti web dei suddetti fact-checker in cui questo contenuto manipolato o prodotto dall’intelligenza artificiale viene smentito.

Lo studio è stato pubblicato sulla rivista Observatorio (OBS*).