Astronomi, fisici ed astrofisici sono alle prese con un problema che sta scombinando le più accreditate teorie sulla nascita e la crescita dell’universo: il valore della costante di Hubble.

In sostanza, non si riesce a trovare un valore univoco relativo alla velocità con cui l’universo si sta espandendo.

In pratica, da quanto abbiamo capito finora, il nostro universo, da quando è emerso dall’esplosione di un minuscolo granello di densità e gravità infinite, ha continuato ad espandersi, ora più velocemente, ora più lentamente, ma, l’unica certezza (speriamo) è che l’espansione dell’universo continua ad accelerare.

Le misurazioni del tasso di espansione dell’universo effettuate utilizzando riferimenti vicini sembrano essere in conflitto con le stesse misurazione basate su riferimenti. Una possibile spiegazione è che nell’universo succede qualcosa che ancora non capiamo che modifica nel tempo la velocità della sua espansione.

Nei giorni scorsi, un fisico teorico italiano ha proposto una soluzione basata su una particella che potrebbe essere la responsabile di questi cambiamenti. Ma su questo ci torneremo più avanti.

La costante di Hubble

Gli astronomi hanno escogitato diversi modi per misurare ciò che chiamano costante di Hubble o H0. Questo numero dovrebbe rappresentare il tasso di espansione dell’universo.

Un modo per misurare il tasso di espansione oggi è osservare le supernove vicine: c’è un particolare tipo di supernova che ha una luminosità molto specifica, quindi possiamo confrontare quanto sono luminose con quanto sappiamo che dovrebbero essere e calcolare così la loro distanza da noi.

Così, guardando la luce dalla galassia che ospita la supernova, gli astrofisici possono calcolare la velocità con cui si sta allontanando da noi. Mettendo insieme tutti i pezzi, possono calcolare il tasso di espansione dell’universo.

Ma c’è di più nell’universo oltre alle stelle che esplodono.

C’è anche qualcosa chiamato sfondo cosmico a microonde, che il residuo della prima luce emessa dopo il Big Bang, quando l’universo era nato da soli 380.000 anni. Grazie al satellite Planck incaricato di mappare questa radiazione residua, gli scienziati hanno mappe incredibilmente precise di questo sfondo, che possono essere utilizzate per ottenere un’immagine molto accurata dei contenuti dell’universo. E da lì, attraverso i modelli computerizzati gli scienziati sono in grado di dire quale dovrebbe essere il tasso di espansione oggi – supponendo che gli ingredienti fondamentali dell’universo non siano cambiati da allora.

Queste due stime non coincidono e gli scienziati si sono convinti che manchi qualcosa nei nostri modelli che giustifichi questa discrasia.

Poiché una misurazione proviene dall’universo primordiale e un’altra proviene da tempi relativamente recenti, il pensiero è che forse c’è un nuovo ingrediente nel cosmo che sta alterando il tasso di espansione dell’universo in un modo che sfugge ai nostri modelli.

Supponiamo che l’espansione dell’universo sia provocata da un fenomeno misterioso che chiamiamo energia oscura, un nome suggestivo per qualcosa che praticamente non capiamo. Tutto ciò che sappiamo è che il tasso di espansione dell’universo oggi sta accelerando e chiamiamo la forza che guida questa accelerazione “energia oscura”.

Finora, i fisici hanno presunto che l’energia oscura (qualunque cosa sia) sia costante. Ma con questo presupposto, non ci tornano i conti, non si riesce ad assegnare un valore univoco alla costante di Hubble, quindi forse l’energia oscura sta cambiando.

Bene. Supponiamo che l’energia oscura stia cambiando.

I fisici hanno il sospetto che l’energia oscura abbia qualcosa a che fare con l’energia bloccata nel vuoto dello spazio-tempo stesso. Questa energia proviene da tutti i “campi quantistici” che permeano l’universo.

Nella moderna fisica quantistica, ogni singolo tipo di particella è legata al suo campo particolare. Questi campi attraversano tutto lo spazio-tempo, e a volte frammenti di questi campi si eccitano, diventando particelle come elettroni, quark e neutrini.

Tutti gli elettroni appartengono al campo degli elettroni, tutti i neutrini appartengono al campo dei neutrini e così via. L’interazione di questi campi costituisce la base fondamentale per la nostra comprensione del mondo quantistico.

Non importa dove tu sia nell’universo, non puoi sfuggire ai campi quantistici. Anche quando non vibrano abbastanza in una particolare posizione per creare una particella, sono ancora lì, che si muovono e vibrano e fanno le loro cose quantistiche. Quindi questi campi quantistici hanno una quantità fondamentale di energia associata a loro, anche nel vuoto stesso.

Se vogliamo usare l’energia quantistica esotica del vuoto dello spazio-tempo per spiegare l’energia oscura, ci imbattiamo immediatamente in diversi problemi.

Quando eseguiamo alcuni calcoli molto semplici su quanta energia c’è nel vuoto a causa di tutti i campi quantistici, finiamo con un numero che è di circa 120 ordini di grandezza maggiore di ciò che osserviamo come energia oscura.

D’altra parte, quando proviamo calcoli più sofisticati, finiamo con un numero che è zero. Che non è d’accordo con la quantità misurata di energia oscura.

Quindi, qualunque cosa accada, facciamo davvero fatica a capire l’energia oscura attraverso il linguaggio dell’energia del vuoto dello spazio-tempo (l’energia creata da quei campi quantici).

Ma se le misurazioni del tasso di espansione sono accurate e l’energia oscura sta davvero cambiando, allora questo potrebbe darci un indizio sulla natura di quei campi quantistici. In particolare, se l’energia oscura sta cambiando, ciò significa che i campi quantistici stessi sono cambiati.

Una nuova particella

Torniamo al fisico italiano e alla sua nuova particella.

In un recente articolo pubblicato online sulla rivista di prestampa arXiv, il fisico teorico Massimo Cerdonio, dell’Università di Padova, ha calcolato l’entità del cambiamento nei campi quantici necessario per spiegare il cambiamento nell’energia oscura.

Se esiste un nuovo campo quantico responsabile del cambiamento nell’energia oscura, ciò significa che c’è una nuova particella nell’universo.

E la quantità di cambiamento nell’energia oscura calcolata da Cerdonio richiede un certo tipo di massa di particelle, che risulta essere approssimativamente la stessa massa di un tipo di particella ipotizzata da tempo: il cosiddetto assione.

I fisici hanno ipotizzato questa particella teorica per risolvere alcuni problemi con la nostra comprensione quantistica della forza forte nucleare.

Presumibilmente, questa particella apparve nell’universo primordiale insieme a tutte le altre ma potrebbe essere rimasta silenziosamente sulla sfondo mentre altre forze e particelle controllavano la direzione dell’universo.

Ora è successo qualcosa e l’assione sta salendo prepotentemente alla ribalta.

In realtà, nessuno ha mai visto un assione, né è stato rilevato per via indiretta. Se questi calcoli sono corretti, però, l’assione ci deve essere e sta riempiendo l’universo e il suo campo quantico.

Inoltre, questo ipotetico assione si sta già rendendo evidente modificando la quantità di energia oscura nel cosmo.

Quindi potrebbe essere che, anche se non l’abbiamo mai vista in laboratorio, questa particella stia già alterando il nostro universo su scale molto grandi.

Fonte: Live Science.

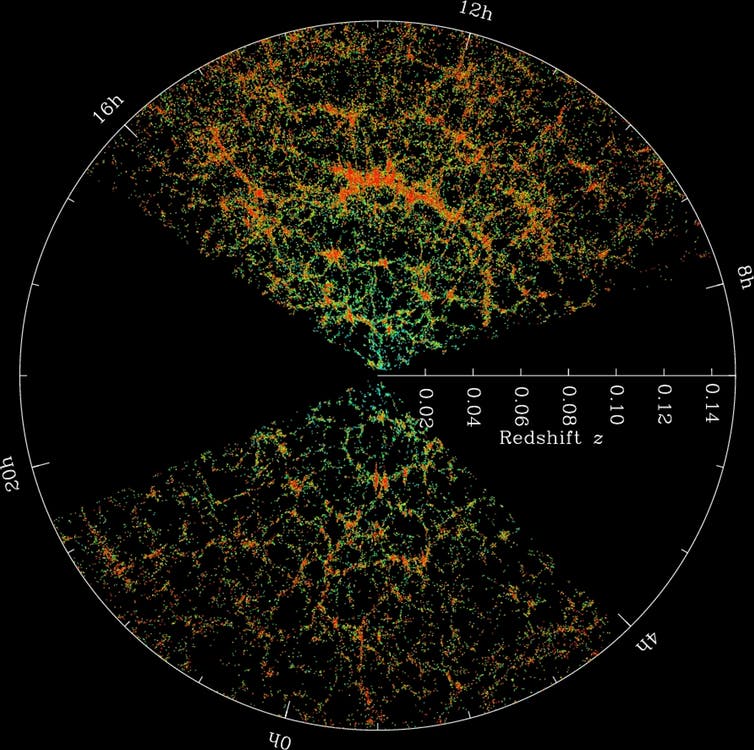

Mappa SDSS – ogni punto è una galassia. (M. Blanton / SDSS / CC BY-SA)

Mappa SDSS – ogni punto è una galassia. (M. Blanton / SDSS / CC BY-SA) (Vernazza et al., Nature Astronomy, 2019)

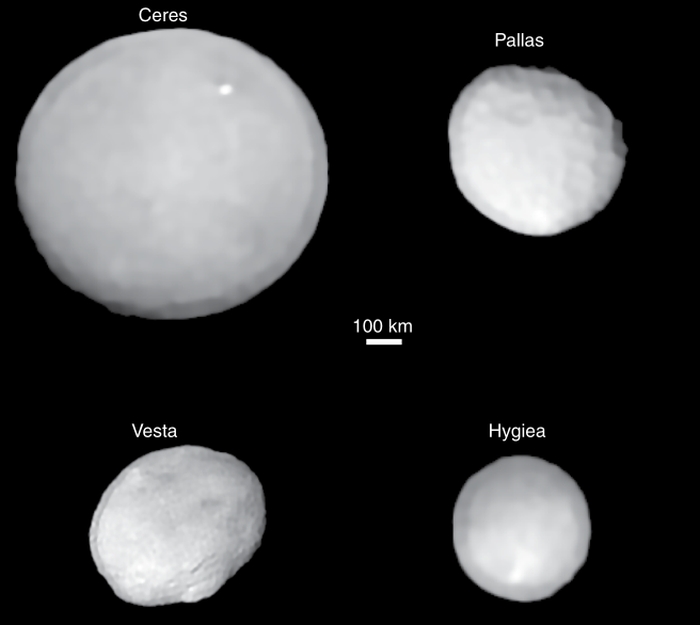

(Vernazza et al., Nature Astronomy, 2019)