I ricercatori hanno sviluppato un metodo in grado di rivelare la posizione degli errori nei computer quantistici, rendendoli fino a dieci volte più facili da correggere. Ciò accelererà in modo significativo il progresso verso computer quantistici su larga scala in grado di affrontare i problemi computazionali più impegnativi del mondo.

Guidato da Jeff Thompson dell’Università di Princeton, il team ha trovato un modo estremamente facile per identificare quando si verificano errori nei computer quantistici. Questo è un nuovo progresso per la ricerca sull’hardware del calcolo quantistico, che spesso cerca semplicemente di ridurre in primo luogo la probabilità che si verifichi un errore.

Correzione degli errori: un approccio innovativo all’informatica quantistica

Un articolo che descrive dettagliatamente il nuovo approccio è stato recentemente pubblicato sulla rivista Nature. Tra i collaboratori di Thompson figurano Shruti Puri dell’Università di Yale e Guido Pupillo dell’Università di Strasburgo.

I fisici hanno inventato nuovi qubit – il componente principale dei computer quantistici – da quasi tre decenni e hanno migliorato costantemente tali qubit per renderli meno fragili e meno soggetti a errori. Ma alcuni tuttavia sono inevitabili. L’ostacolo centrale al futuro sviluppo dei computer quantistici è la capacità di correggerli.

Per correggere un errore, bisogna prima capire se si è verificato e dove si trova nei dati, e in genere, il processo di controllo introduce ulteriori errori, che devono essere ritrovati e così via.

Secondo Thompson, professore associato di ingegneria elettrica e informatica, la capacità dei computer quantistici di gestire questi inevitabili errori è rimasta più o meno stagnante per un lungo periodo.

Annuncio pubblicitario

Interessato all'Intelligenza Artificiale?

Prova a leggere su Amazon Unlimited la nostra guida su come installarne una in locale e come ricavarne il massimo.

Una Intelligenza Artificiale locale ti permette di usufruire di tutti i vantaggi derivanti dall'uso dell'IA ma senza dover pagare costosi abbonamenti.

📘 Leggi la guida su Amazon

Progressi nella correzione degli errori quantistici

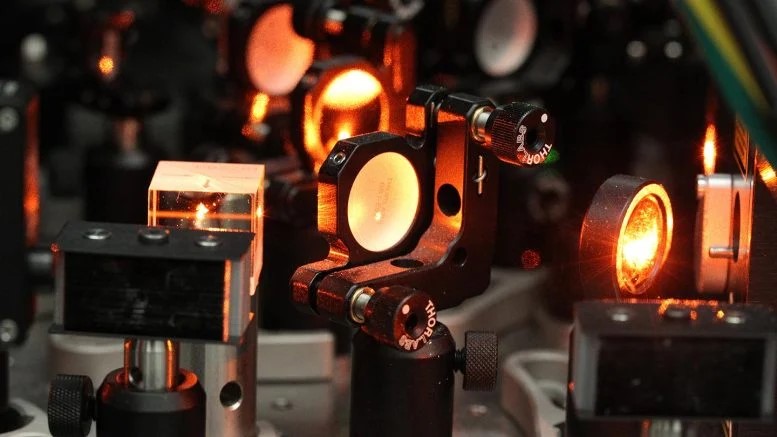

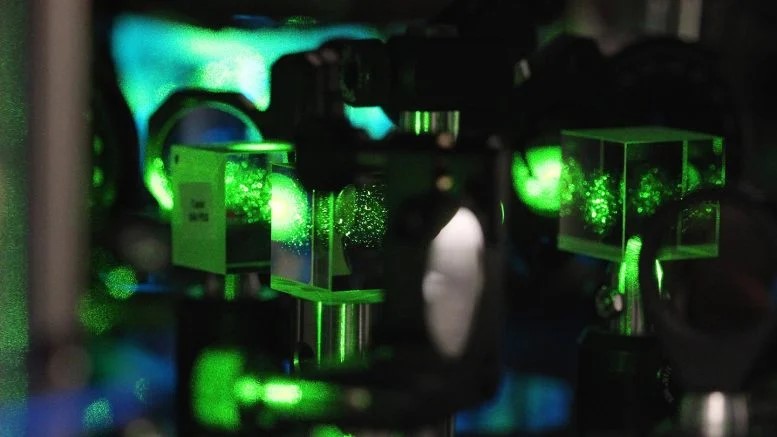

Il laboratorio di Thompson ha lavorato su un tipo di computer quantistico basato su atomi neutri. All’interno della camera ad altissimo vuoto che definisce il computer, i qubit sono immagazzinati nella rotazione dei singoli atomi di itterbio, tenuti in posizione da raggi laser focalizzati chiamati pinzette ottiche. In questo lavoro, un team guidato dallo studente laureato Shuo Ma ha utilizzato una serie di 10 qubit per caratterizzare la probabilità che si verifichi un errore durante la prima manipolazione di ciascuno di essi in isolamento e quindi la manipolazione di coppie di qubit insieme.

Il risultato non riguarda solo i bassi tassi di errore, ma anche un modo diverso di caratterizzarli senza distruggere i qubit. Utilizzando un diverso insieme di livelli energetici all’interno dell’atomo per immagazzinarli, rispetto al lavoro precedente, i ricercatori sono stati in grado di monitorarli durante il calcolo per rilevare il verificarsi di errori in tempo reale. Questa misurazione ha fatto sì che i qubit con errori emettano un lampo di luce, mentre quelli senza rimangono scuri e non sono interessati.

Questo processo converte gli errori in un tipo di errore noto come errore di cancellazione.

Gli errori di cancellazione sono stati studiati nel contesto dei qubit realizzati da fotoni e sono noti da tempo per essere più semplici da correggere rispetto agli errori in posizioni sconosciute, ha affermato Thompson. Questa è la prima volta che il modello dell’errore di cancellazione viene applicato ai qubit basati sulla materia, e fa seguito a una proposta teorica avanzata lo scorso anno da Thompson, Puri e Shimon Kolkowitz dell’Università della California-Berkeley.

Nella dimostrazione, circa il 56% degli errori da un qubit e il 33% degli errori da due qubit sono stati rilevabili prima della fine dell’esperimento.

Fondamentalmente, l’atto di verificare la presenza di errori non causa un numero significativamente maggiore degli stessi: i ricercatori hanno dimostrato che il controllo ha aumentato il tasso di errore di meno dello 0,001%. Secondo Thompson, la frazione di errori rilevati può essere migliorata con un ulteriore intervento di ingegneria.

I ricercatori ritengono che, con il nuovo approccio, quasi il 98% di tutti gli errori dovrebbero essere rilevabili con protocolli ottimizzati. Questo potrebbe ridurre i costi computazionali legati all’implementazione della correzione di un ordine di grandezza o più.

Altri gruppi hanno già iniziato ad adattare questa nuova architettura di rilevamento.

I ricercatori di Amazon Web Services e un gruppo separato di Yale hanno dimostrato in modo indipendente come questo nuovo paradigma possa anche migliorare i sistemi che utilizzano qubit superconduttori.

“Abbiamo bisogno di progressi in molte aree diverse per consentire un calcolo quantistico utile e su larga scala. Una delle sfide dell’ingegneria dei sistemi è che i progressi che si ottengono non sempre si sommano in modo costruttivo. Possono portarti in direzioni diverse”, ha detto Thompson. “La cosa bella della conversione di cancellazione è che può essere utilizzata in molti qubit e architetture di computer diversi, quindi può essere implementata in modo flessibile in combinazione con altri sviluppi”, hanno concluso.