Un recente studio propone un’ipotesi rivoluzionaria che potrebbe ridefinire la nostra comprensione dell’universo. La ricerca suggerisce che le informazioni quantistiche, intrinsecamente codificate nell’entropia dell’entanglement, modellano direttamente la struttura dello spaziotempo.

Questa idea innovativa apre un nuovo orizzonte verso l’ambiziosa unificazione della gravità, descritta dalla relatività generale di Einstein, e della meccanica quantistica, il regno dell’infinitamente piccolo.

Entanglement quantistico: la chiave per unificare gravità e meccanica quantistica?

Il cuore di questo studio risiede in una riformulazione delle celebri equazioni di campo di Einstein. La prospettiva convenzionale vede la gravità come una manifestazione della risposta dello spaziotempo alla presenza di massa ed energia. Tuttavia, la nuova ricerca introduce un concetto audace: la gravità non sarebbe determinata unicamente da questi fattori, ma anche dalla sottile struttura informativa intrinseca ai campi quantistici. Se questa ipotesi dovesse trovare conferma, rappresenterebbe un cambiamento paradigmatico nel modo in cui i fisici interpretano sia la forza di gravità che i principi fondamentali del calcolo quantistico.

Lo studio, pubblicato da Florian Neukart del Leiden Institute of Advanced Computer Science, Università di Leida, e Chief Product Officer di Terra Quantum, introduce la nozione di un inedito “tensore energia-stress informativo“. Questo tensore deriverebbe direttamente dall’entropia dell’entanglement quantistico. L’entropia dell’entanglement è una misura del grado di correlazione quantistica che intercorre tra diverse regioni dello spazio.

Essa gioca un ruolo cruciale sia nella teoria dell’informazione quantistica che nel campo del calcolo quantistico. Proprio perché l’entanglement cattura la maniera in cui l’informazione viene condivisa attraverso i confini spaziali, esso si configura come un ponte naturale che connette il mondo della teoria quantistica con il tessuto geometrico dello spaziotempo.

Nella relatività generale classica, la curvatura dello spaziotempo è univocamente determinata dalla distribuzione di energia e quantità di moto della materia e della radiazione presenti nell’universo. Il nuovo modello proposto aggiunge a questo quadro un ulteriore elemento fondamentale: l’informazione quantistica condivisa tra i campi. Questo termine aggiuntivo apporta una modifica significativa alle equazioni di Einstein, offrendo potenzialmente una spiegazione per alcuni dei comportamenti più sfuggenti e misteriosi della gravità, inclusa la possibilità di correzioni alla costante gravitazionale di Newton.

Per i ricercatori attivi nel campo del calcolo quantistico, questo studio rafforza un’idea già emergente: l’entanglement non è semplicemente una risorsa computazionale da sfruttare, ma potrebbe rappresentare un elemento strutturale fondamentale dell’universo stesso. La ricerca implica che, nel momento in cui i sistemi di calcolo quantistico manipolano l’entanglement, essi attingono agli stessi meccanismi che influenzano e plasmano la forma dello spaziotempo.

Questa profonda dualità tra la geometria dello spaziotempo e l’informazione quantistica, come sottolinea lo studio, ha implicazioni di vasta portata per la nostra comprensione del cosmo. In particolare, suggerisce con forza che la gravità potrebbe emergere dall’intricato fenomeno dell’entanglement a livello quantistico. Questa visione si allinea con le attuali ricerche in corso nel campo della gravità quantistica, che includono promettenti teorie come l’approccio olografico e la corrispondenza AdS/CFT.

Correzioni alla costante di Newton e campi quantistici

A sostegno della sua audace ipotesi, lo studio condotto da Neukart presenta calcoli dettagliati riguardanti le correzioni alla fondamentale costante gravitazionale di Newton. Questi calcoli si basano sull’entropia di entanglement derivante da diverse tipologie di campi quantistici, che includono campi scalari, spinoriali e bosoni di gauge.

Sebbene le correzioni numeriche risultanti siano estremamente piccole, esse rivelano una dipendenza cruciale: la loro entità è legata al contenuto quantistico dei campi che permeano l’universo e varia significativamente con la scala energetica considerata. Questa scoperta suggerisce un’implicazione profonda: l’intensità della forza di gravità potrebbe non essere una costante universale e immutabile, come tradizionalmente assunto.

Nel suo lavoro, Neukart impiega strumenti ben consolidati e potenti della teoria quantistica dei campi. Tra questi spiccano il “trucco della replica” e i sofisticati “metodi del kernel di calore“. Queste tecniche avanzate permettono di modellare con precisione il modo in cui regioni dello spazio intrinsecamente entangled influenzano la curvatura dello spaziotempo. In sostanza, questi metodi consentono ai fisici di calcolare la propagazione e l’interazione dell’informazione quantistica all’interno di uno spaziotempo curvo, analogamente a come si studierebbe la diffusione del calore attraverso sistemi complessi.

I risultati ottenuti dai meticolosi calcoli del ricercatore indicano che persino regioni infinitesime di correlazione quantistica possono esercitare un’influenza non trascurabile sulla dinamica gravitazionale. Questo effetto si manifesterebbe in modo particolarmente significativo in prossimità di oggetti celesti estremi come i buchi neri e nelle condizioni energetiche estreme che caratterizzavano l’universo primordiale.

Una delle implicazioni più sorprendenti di questa ricerca riguarda la termodinamica dei buchi neri, un campo di studio affascinante che fonde concetti di gravità, termodinamica e meccanica quantistica. Le equazioni tradizionali che descrivono l’entropia e la temperatura dei buchi neri si basano sull’assunzione che la costante di Newton sia un valore fisso. Tuttavia, se la forza di gravità dovesse “correre” con la scala energetica, come suggerito dallo studio, anche queste grandezze termodinamiche subirebbero delle modifiche. In particolare, l’entropia di un buco nero tenderebbe a diminuire leggermente alle alte energie, mentre la sua temperatura aumenterebbe, portando potenzialmente a tassi di evaporazione più lenti di quanto previsto.

Sebbene queste sottili correzioni siano al di là della portata della nostra attuale tecnologia di rilevamento, esse aprono una promettente finestra teorica sul celebre paradosso dell’informazione dei buchi neri. Questo paradosso rappresenta una delle tensioni irrisolte più profonde e stimolanti tra i pilastri fondamentali della fisica moderna: la meccanica quantistica e la teoria della relatività generale di Einstein.

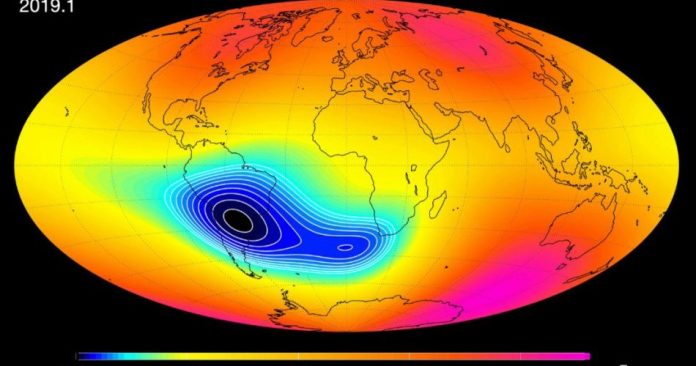

Le implicazioni di questa ricerca potrebbero estendersi ben oltre il regno dei buchi neri. La dipendenza della gravità dalla scala energetica potrebbe aver influenzato in modo significativo fenomeni cosmologici cruciali come l’inflazione, la fase di rapida espansione dell’universo primordiale governata da equazioni che includono la costante di Newton. Se quest’ultima fosse stata leggermente inferiore alle energie estreme dell’universo neonato, la dinamica dell’inflazione potrebbe essere stata differente. Allo stesso modo, processi fondamentali come la nucleosintesi primordiale, la formazione degli elementi leggeri, e persino le caratteristiche della radiazione cosmica di fondo a microonde potrebbero conservare tracce di questa variazione della forza di gravità.

Inoltre, la ricerca suggerisce una connessione interessante: l’entanglement quantistico potrebbe addirittura fornire un contributo significativo alla costante cosmologica, il misterioso parametro spesso invocato per spiegare l’enigmatica energia oscura e l’accelerata espansione dell’universo che osserviamo oggi.

Rilevanza alla scala di Planck e limiti delle tecniche perturbative

Nonostante l’indubbia eleganza e la profonda portata concettuale della teoria proposta, essa si confronta con sfide significative, in particolare per quanto riguarda la verifica sperimentale delle sue previsioni. Le variazioni previste nella costante di Newton, elemento centrale della teoria, risultano essere straordinariamente piccole, collocandosi ben al di sotto della soglia di sensibilità degli strumenti di misurazione attualmente disponibili.

È importante sottolineare che la maggior parte delle correzioni derivate da questo studio acquisisce una rilevanza significativa unicamente in prossimità della cosiddetta scala di Planck. Questa scala energetica estrema è il punto in cui si prevede che gli effetti gravitazionali e quantistici si manifestino congiuntamente e in modo inestricabile.

Inoltre, i risultati presentati si basano sull’impiego di tecniche perturbative, la cui validità e accuratezza tendono a diminuire drasticamente in regimi di energia così elevati. Lo studio stesso riconosce apertamente questa intrinseca limitazione e sottolinea l’urgente necessità di sviluppare approcci teorici non perturbativi, come i potenti metodi del gruppo di rinormalizzazione esatta, al fine di estendere l’applicabilità e la solidità della teoria in questi contesti estremi.

Un altro aspetto cruciale da considerare è che il quadro teorico proposto si basa su specifiche ipotesi riguardanti il contenuto di particelle fondamentali che costituiscono l’universo. Prendendo come punto di partenza il Modello Standard della fisica delle particelle, le correzioni calcolate risultano essere minime. Teorie che vanno oltre i confini del Modello Standard – come quelle che postulano l’esistenza di nuovi campi fondamentali o di dimensioni spaziali extra – potrebbero potenzialmente amplificare in modo significativo questi effetti previsti.

In definitiva, è fondamentale riconoscere che questo studio pionieristico non ambisce a fornire una soluzione completa e definitiva al complesso problema della gravità quantistica. Piuttosto, il suo valore risiede nella riformulazione radicale del problema stesso. Dimostrando come l’enigmatica entropia dell’entanglement possa essere integrata matematicamente all’interno delle consolidate equazioni di campo di Einstein, la ricerca apre una promettente e inedita via che connette intrinsecamente la struttura dello spaziotempo con il concetto di informazione – un’idea familiare e centrale sia per gli informatici quantistici che per i fisici teorici.

Le future direzioni di ricerca richiederanno un programma di indagine ampio e approfondito per consolidare e sviluppare ulteriormente le basi concettuali gettate da questo studio innovativo. L’autore stesso suggerisce che gli esperimenti quantistici emergenti, tra cui le misurazioni di precisione della forza di gravità a distanze estremamente brevi e le tecniche avanzate di imaging dei buchi neri, potrebbero in futuro fornire un supporto indiretto, ma cruciale, alla validità della teoria proposta.

Dati astrofisici sempre più precisi, segnali provenienti da onde gravitazionali e osservazioni condotte ad altissime energie potrebbero offrire ulteriori indizi e vincoli sperimentali, soprattutto con il continuo miglioramento della sensibilità e della risoluzione degli strumenti osservativi. La proposta incoraggia inoltre attivamente i ricercatori che lavorano nel campo dell’informazione quantistica a considerare il proprio lavoro all’interno di un contesto teorico più ampio, contribuendo potenzialmente a far luce su una delle questioni irrisolte più interessanti e profonde della fisica fondamentale.

Come alcuni ricercatori descrivono con suggestiva metafora, questi sforzi congiunti alludono all’esistenza di un vero e proprio “sistema operativo informativo” sottostante al cosmo, in cui la struttura fondamentale della realtà emergerebbe non solo dalla materia o dall’energia, ma dal dinamico flusso e dall’intricata struttura dell’informazione stessa.

Lo studio è stato pubblicato su Annals of Physics.