Il 2024 ha visto una crescita esponenziale nella generazione di video tramite intelligenza artificiale, con nuovi modelli che emergono a un ritmo vertiginoso. La scorsa settimana, nomi come Sora di OpenAI, Pika 2 di Pika AI, Veo 2 di Google e video-01-live di Minimax e HunyuanVideo hanno fatto scalpore, offrendo capacità sempre più sofisticate e realiste.

L’Impatto di HunyuanVideo e l’Open Source

In questo panorama in rapida evoluzione, HunyuanVideo di Tencent si distingue per un approccio innovativo. A differenza dei suoi concorrenti, che mantengono i propri modelli come proprietà intellettuale, adotta un modello open-source, rendendo disponibili i pesi della sua rete neurale. Questa scelta ha importanti implicazioni.

Chiunque disponga di una GPU sufficientemente potente (come una VRAM da 24 GB) può eseguire il modello localmente, senza dover dipendere da servizi cloud. Gli utenti possono ottimizzare il modello o utilizzarlo con tecniche come LoRA per insegnargli nuovi concetti e stili. Un approccio open-source favorisce lo sviluppo di una comunità attiva di ricercatori e sviluppatori, accelerando l’innovazione.

Le aziende cinesi sono state particolarmente attive nel campo dei video AI, e alcuni esperti attribuiscono questo dinamismo a una maggiore flessibilità nell’utilizzo dei dati di addestramento. In particolare, si ipotizza che queste aziende siano meno restie a utilizzare contenuti protetti da copyright, immagini di celebrità e persino fonti video non censurate.

HunyuanVideo, in particolare, è in grado di generare video di esseri umani nudi anatomicamente realistici. Questa capacità, pur essendo tecnicamente impressionante, solleva preoccupazioni riguardo all’uso improprio di questa tecnologia per creare contenuti pornografici o diffondere disinformazione.

La rivoluzione dei video AI è in piena espansione, e le implicazioni di questa tecnologia sono profonde e complesse. Da un lato, abbiamo assistito a progressi straordinari nella generazione di contenuti video realistici e personalizzabili. Dall’altro, emergono questioni etiche e legali che richiedono un’attenta riflessione.

Annuncio pubblicitario

Interessato all'Intelligenza Artificiale?

Prova a leggere su Amazon Unlimited la nostra guida su come installarne una in locale e come ricavarne il massimo.

Una Intelligenza Artificiale locale ti permette di usufruire di tutti i vantaggi derivanti dall'uso dell'IA ma senza dover pagare costosi abbonamenti.

📘 Leggi la guida su AmazonPro e contro

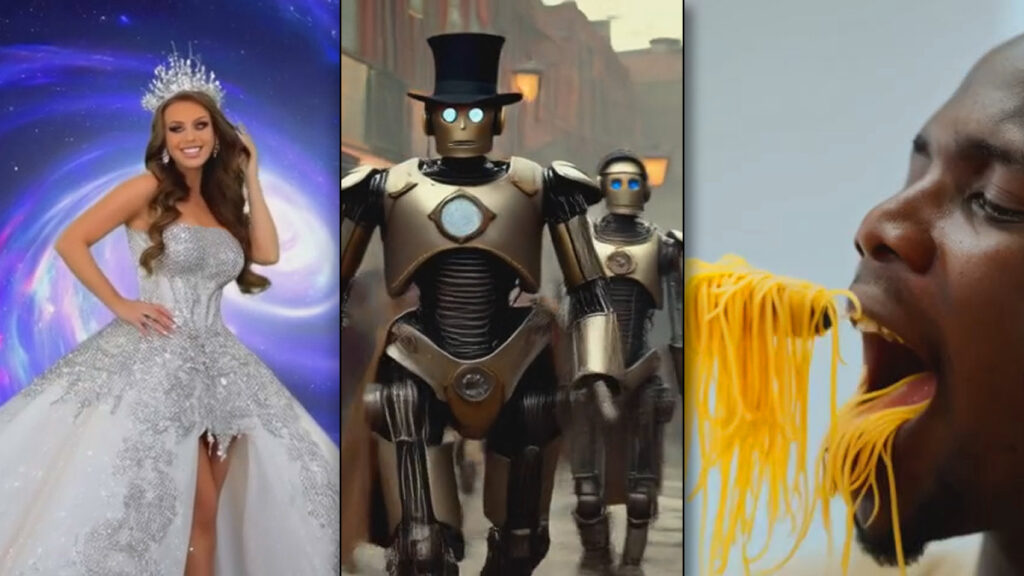

Mettendo alla prova le capacità di HunyuanVideo nella generazione di brevi clip video. I risultati ottenuti sono stati incoraggianti, dimostrando come questo modello, pur essendo ancora in fase di sviluppo, sia in grado di competere con soluzioni commerciali più affermate come Gen-3 Alpha e Minimax video-01.

La generazione di un video ha richiesto un tempo medio di circa sette-nove minuti e un costo di circa $0,70. Nonostante ciò, la possibilità di eseguire il modello localmente e di ottimizzarlo offre un notevole potenziale di risparmio a lungo termine. I video generati presentano una qualità visiva generalmente buona, sebbene siano evidenti alcuni limiti, come la presenza di artefatti e la difficoltà nel rappresentare correttamente alcune scene complesse.

La natura open-source di HunyuanVideo consente agli utenti di personalizzare il modello in base alle proprie esigenze, ad esempio attraverso l’aggiunta di nuovi dati di addestramento o la modifica dell’architettura della rete neurale. In un confronto con altri modelli di punta, come Sora di OpenAI e Google Veo 2. Mentre Sora ha dimostrato di essere più coerente nel seguire i prompt, HunyuanVideo si è rivelato più flessibile e personalizzabile. Tuttavia, tutti i modelli presentano ancora alcune limitazioni, come la difficoltà nel gestire scene complesse o nel rappresentare accuratamente le celebrità.

Nonostante i suoi limiti attuali, ha il potenziale per rivoluzionare il settore della produzione video. Tuttavia, lo sviluppo di modelli come HunyuanVideo solleva anche una serie di questioni etiche e legali, legate alla proprietà intellettuale, alla privacy e alla diffusione di contenuti falsi o deepfake.

Conclusioni

HunyuanVideo rappresenta un passo importante verso la democratizzazione della sintesi video AI. Sebbene siano ancora presenti numerose sfide, il futuro di questa tecnologia si preannuncia estremamente promettente.