Sebbene nel mondo occidentale contemporaneo la svastica sia indissolubilmente legata agli orrori perpetrati durante la Seconda Guerra Mondiale e al regime nazista, la sua esistenza precede di gran lunga la sua adozione come emblema di quell’aberrante ideologia.

Questo antico disegno è stato – e continua ad essere – un motivo ricorrente in svariate religioni e culture in tutto il globo, spesso intriso di significati positivi come la fortuna, la prosperità o la spiritualità.

La svastica pre-nazista: un simbolo di fortuna e spiritualità riscoperto in Francia

Recentemente, in Francia, una scoperta archeologica di notevole importanza ha riportato alla luce questa storia millenaria: gli archeologi hanno rinvenuto due spade deposte all’interno di una necropoli celtica risalente a circa 2.300 anni fa, una delle quali sfoggia piccole ma significative decorazioni a svastica incise sul suo fodero in rame.

Gli archeologi dell’Istituto nazionale francese di ricerca archeologica preventiva (INRAP) hanno espresso il loro stupore in una dichiarazione ufficiale, descrivendo gli ornamenti metallici e le armi recuperate dalla tomba, insolitamente priva di resti scheletrici, come manufatti di “fabbricazione eccezionale” e di cui si riscontrano “pochi equivalenti” in tutto il panorama europeo.

Entrambe le spade sono state ritrovate all’interno dei loro foderi originali, preservando così un contesto archeologico di grande valore. Una delle due è stata definita senza esitazione “l’oggetto più spettacolare dell’intera necropoli“. L’impugnatura e la placca frontale del fodero, concepito per essere elegantemente portato alla cintura, erano realizzate in rame e riccamente ornate con decorazioni a forma di occhio, un motivo artistico noto come ocelli. Pietre preziose impreziosivano ulteriormente l’esterno del fodero finemente lavorato, e tra queste decorazioni spiccano almeno due rappresentazioni del simbolo della svastica.

La spada stessa si presenta come una lama corta e sottile, caratterizzata da un’impugnatura in ferro dalla distintiva forma “a antenna“. Il team di ricerca ha impiegato la tecnologia dei raggi X per rivelare incisioni nascoste sulla parte superiore della lama, tra cui la probabile raffigurazione di un sole e di una falce di luna, originariamente separati da una linea incisa. Vincent Georges, archeologo dell’INRAP e responsabile dello scavo, ha spiegato che questi simboli cosmologici chiave rappresentavano collettivamente un “concetto sacro molto diffuso e profondamente radicato in questo particolare tipo di spada” all’inizio del IV secolo a.C., un periodo in cui tale simbolismo era particolarmente “di moda tra gli artigiani celtici”.

Una spada di Stato e un’arma funzionale dalla necropoli celtica

In virtù della sua elaborata ornamentazione, l’archeologo Vincent Georges ipotizza che la spada recante le svastiche fosse con ogni probabilità un oggetto cerimoniale, privo di una vera funzionalità bellica, destinato piuttosto a manifestare lo status sociale e militare del suo possessore. Sebbene non possa affermarlo con assoluta certezza, Georges suggerisce che la spada potrebbe essere stata forgiata all’epoca delle incursioni celtiche nell’Italia settentrionale, un periodo culminato con il famoso sacco di Roma nel 383 a.C.

La seconda spada rinvenuta nella necropoli presenta una foggia più lunga ed è dotata di anelli che ne avrebbero permesso il pratico trasporto alla cintura. Pur esibendo un apparato decorativo meno sfarzoso rispetto alla prima, anch’essa presenta gemme incastonate nella parte superiore del fodero e decorazioni a forma di ocelli. All’interno del fodero sono stati inoltre identificati resti di tessuto, che secondo la dichiarazione degli archeologi potrebbero provenire dalle vesti del defunto, da un sudario o da un qualche tipo di involucro protettivo. Il design più funzionale di questa seconda spada, unitamente al ritrovamento di tracce tessili, suggerisce che essa potrebbe essere stata effettivamente utilizzata per lo scopo per cui era stata concepita, ovvero il combattimento.

Gli esperti concordano nel datare entrambe le spade al IV secolo a.C. Secondo l’archeologo Georges, le svastiche erano un motivo ornamentale ampiamente diffuso nel bacino del Mediterraneo in quell’epoca, e la cultura celtica adottò questo simbolo nel suo espandersi nell’Europa continentale. Gli studiosi ritengono che il primo impiego celtico della svastica avesse lo scopo di evocare il movimento del sole attraverso il cielo, assumendo così un significato simbolico legato alla buona fortuna e al ciclo vitale.

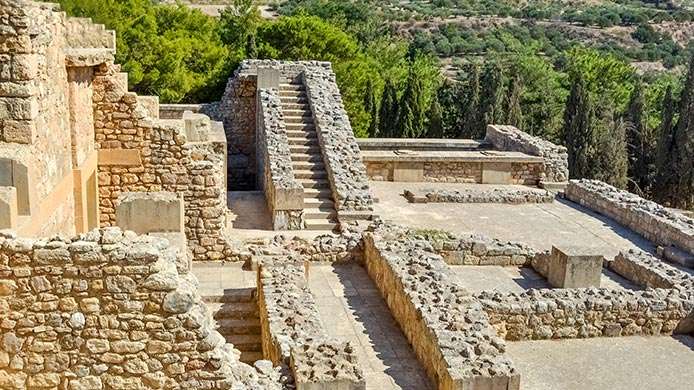

Creuzier-le-Neuf: un’Importante necropoli celtica rivelata dagli scavi

Gli scavi condotti nella località francese di Creuzier-le-Neuf, un sito che in epoca antica rappresentava un crocevia di significative tribù celtiche, si sono estesi su un’area di 650 metri quadrati, portando alla luce un’estesa necropoli composta da oltre 100 sepolture risalenti alla Seconda Età del Ferro. La particolare acidità del terreno ha impedito la conservazione dei resti scheletrici, e il sito ha restituito un’unica sepoltura a cremazione, caratterizzata dalla presenza del vaso cinerario.

Un aspetto notevole emerso dagli scavi è la presenza di ornamenti metallici in circa la metà delle tombe esplorate. Tra questi, i bracciali rappresentavano la tipologia di manufatto più comune: molti si presentavano come semplici anelli in rame laminato, mentre altri sfoggiavano decorazioni più elaborate, anelli aggiuntivi o sistemi di chiusura. Il team archeologico ha inoltre rinvenuto un totale di 18 spille realizzate in rame o in ferro, tra le quali spicca un esemplare particolarmente impressionante, ornato con un motivo che includeva gemme e delicate foglie d’argento.

Nonostante la varietà e la pregevole fattura dei numerosi reperti metallici, nulla ha eguagliato la straordinarietà della spada risalente al IV secolo a.C., precedentemente descritta, la cui ricca decorazione comprendeva sia gemme preziose che il significativo simbolo della svastica. Questo manufatto unico si distingue come il reperto più notevole e di maggior valore scientifico rinvenuto nell’intera necropoli di Creuzier-le-Neuf.

Il ritrovamento è stato documentato sul sito academia.eu