La nostra percezione del nostro corpo non è sempre corretta o realistica, come sa qualsiasi atleta o persona attenta alla moda, ma è un fattore cruciale nel modo in cui ci comportiamo nella società. Il tuo cervello si prepara continuamente al movimento mentre giochi a palla o ti vesti, in modo da poter muovere il tuo corpo senza urtare, inciampare o cadere.

Gli esseri umani sviluppano i nostri modelli corporei da bambini e i robot stanno iniziando a fare lo stesso. Un team della Columbia Engineering ha rivelato di aver sviluppato un robot che, per la prima volta, può imparare da zero un modello di tutto il suo corpo senza alcun aiuto umano. I ricercatori spiegano come il loro robot ha costruito un modello cinematico di se stesso in un recente articolo pubblicato su Science Robotics e come ha utilizzato quel modello per pianificare i movimenti, raggiungere obiettivi ed evitare ostacoli in una serie di scenari. Anche i danni al suo corpo sono stati automaticamente rilevati e corretti.

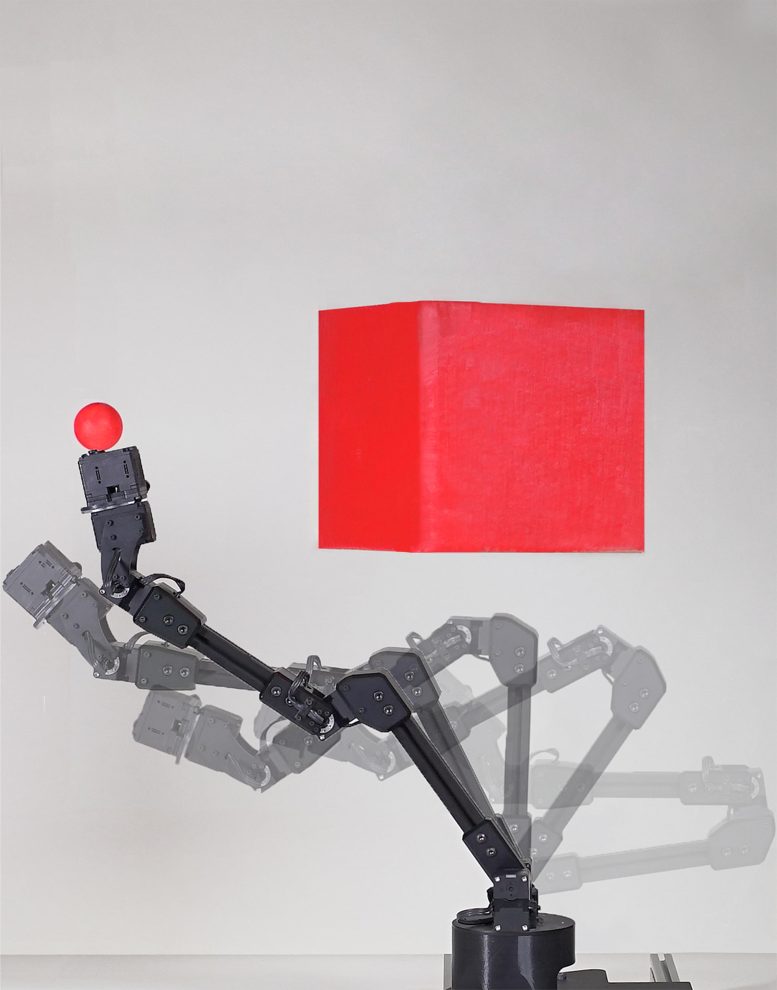

Un robot può apprendere la morfologia dell’intero corpo tramite l’automodellazione visiva per adattarsi a molteplici attività di pianificazione e controllo del movimento. Credito: Jane Nisselson e Yinuo Qin/ Columbia Engineering

Il robot si osserva come un bambino che si esplora in una sala degli specchi

I ricercatori hanno posizionato un braccio robotico all’interno di un cerchio di cinque videocamere in streaming. Il robot si osservava attraverso le telecamere mentre ondeggiava liberamente. Come un bambino che esplora se stesso per la prima volta in una sala degli specchi, il robot si dimenava e si contorceva per apprendere come si muoveva esattamente il suo corpo in risposta a vari comandi motori. Dopo circa tre ore, il robot si è fermato. La sua rete neurale profonda interna aveva finito di apprendere la relazione tra le azioni motorie del robot e il volume che occupava nel suo ambiente.

I robot ad automodellazione porteranno a sistemi autonomi più autosufficienti

La capacità dei robot di modellarsi da soli senza essere assistiti dagli ingegneri è importante per molte ragioni: non solo consente di risparmiare manodopera, ma consente anche al robot di tenere il passo con la propria usura e persino di rilevare e compensare i danni. Gli autori sostengono che questa capacità è importante poiché abbiamo bisogno di sistemi autonomi che siano più autosufficienti. Un robot di fabbrica, ad esempio, potrebbe rilevare che qualcosa non si sta muovendo correttamente e compensare o richiedere assistenza.

Annuncio pubblicitario

Interessato all'Intelligenza Artificiale?

Prova a leggere su Amazon Unlimited la nostra guida su come installarne una in locale e come ricavarne il massimo.

Una Intelligenza Artificiale locale ti permette di usufruire di tutti i vantaggi derivanti dall'uso dell'IA ma senza dover pagare costosi abbonamenti.

📘 Leggi la guida su Amazon“Noi umani abbiamo chiaramente una nozione di sé“, ha spiegato il primo autore dello studio Boyuan Chen, che ha guidato il lavoro ed è ora assistente professore alla Duke University. “Chiudi gli occhi e prova a immaginare come si muoverebbe il tuo corpo se dovessi fare qualche azione, come allungare le braccia in avanti o fare un passo indietro. Da qualche parte all’interno del nostro cervello abbiamo una nozione di sé, un modello di sé che ci informa quale volume delle nostre immediate vicinanze occupiamo e come quel volume cambia mentre ci muoviamo”.

Autoconsapevolezza nei robot

Il lavoro fa parte della ricerca decennale di Lipson per trovare il modo di garantire ai robot una qualche forma di autocoscienza. “L’auto modellazione è una forma primitiva di autocoscienza“, ha spiegato. “Se un robot, un animale o un essere umano ha un automodello accurato, può funzionare meglio nel mondo, può prendere decisioni migliori e ha un vantaggio evolutivo“.

I ricercatori sono consapevoli dei limiti, dei rischi e delle controversie che circondano la concessione di una maggiore autonomia alle macchine attraverso l’autocoscienza. Lipson si affretta ad ammettere che il tipo di autocoscienza dimostrato in questo studio è, come ha osservato, “banale rispetto a quella degli umani, ma da qualche parte devi iniziare. Dobbiamo procedere lentamente e con attenzione, in modo da poter raccogliere i frutti riducendo al minimo i rischi“.

Riferimento: “Fully body visual self-modeling of robot morphologies” di Boyuan Chen, Robert Kwiatkowski, Carl Vondrick e Hod Lipson, 13 luglio 2022, Science Robotics.

DOI: 10.1126/scirobotics.abn1944